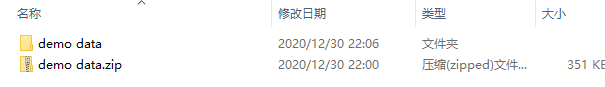

执行上面的代码后,可以在同目录下的 apply/data/demo data 文件夹中看到相同结构内容

压缩文件能帮助我们节省空间和时间。ZIP 是种存档文件,支持无损数据压缩。用 Python 打开 ZIP 文件夹先得有 Zip File 库。

本文所有文件都已打包进独立 ZIP 文件中,来提取看看吧。

from zipfile import ZipFile

# 压缩文件路径

file = './data/demo data.zip'

# 读取并解压内容

with ZipFile (file, 'r') as zip:

zip.printdir()

zip.extractall(path='./data/demo data')

File Name Modified Size Beijing/ 2021-01-09 21:55:24 0 Beijing/1.jpg 2021-01-09 22:00:28 14363 Beijing/2.jpg 2021-01-09 22:00:28 10942 Beijing/3.jpg 2021-01-09 22:00:28 5100 Beijing/4.jpg 2021-01-09 22:00:28 4142 Beijing/5.jpg 2021-01-09 22:00:28 6914 Beijing/6.jpg 2021-01-09 22:00:28 4493 Beijing/7.jpg 2021-01-09 22:00:28 4518 Beijing/8.jpg 2021-01-09 22:00:28 12041 Employee.txt 2021-01-09 22:00:28 85 Liberty Dream.txt 2021-01-09 22:00:28 163 Products.csv 2021-01-09 22:00:28 79 sample_db.sql 2021-01-09 22:00:28 4299 sample_json.json 2021-01-09 22:01:12 120 sample_pickle.pkl 2021-01-09 22:00:28 0 test1.py 2021-01-09 22:00:28 17 test_demo_1.py 2021-01-09 22:00:28 23 test_demo_2.py 2021-01-09 22:00:28 23 test_img1.png 2021-01-09 22:00:28 255274 World_city.xlsx 2021-01-09 22:00:28 11582

执行上面的代码后,可以在同目录下的 apply/data/demo data 文件夹中看到相同结构内容

文本文件算是最常见的文件格式了。Python 用 open() 方法读取指定路径的文件,并用参数指定访问方式。读文件模式为 r,还有其他访问模式:

w —— 写入文件r+ 或 w+ —— 读取并写入文件a —— 追加到既有文本后面a+ —— 读取后再追加Python 提供了三种方法读取文本文件:

read(n) – 从文本中读取 n 个字符,不指定数字就读取全部。可以自动识别定界符并分隔句子。readline(n) – 从文件中读取 n 个字符,但不超过一行readlines() – 读取全部信息,但不同于 read(),该方法不会管分隔符,将其一并读入列表来看看这些方法读文件时的异同吧:

# 读取 text 文件,指定解码格式为 utf-8

with open(r'./data/demo data/Liberty Dream.txt','r',encoding='utf-8') as f:

print(f.read())

欢迎来到 Python 文件导入教程。我们会关注以下文件类型的处理: 1. Text 2. CSV 3. Excel 4. SQL 5. Web 数据 6. Image 阅读愉快!

read() 方法成功以结构化的方式读入了所有数据。

# 读取 text 文件,读取 n 个字节

with open(r'./data/demo data/Liberty Dream.txt','r',encoding='utf-8') as f:

print(f.read(4))

欢迎来到

给 read() 指定一个数后,可以读取定量的字符

# 按行读取 text 文件

with open(r'./data/demo data/Liberty Dream.txt','r',encoding='utf-8') as f:

print(f.readline())

欢迎来到 Python 文件导入教程。我们会关注以下文件类型的处理:

用了 readline(),只读了一行文本进来

# 将 text 文件解析成列表

with open(r'./data/demo data/Liberty Dream.txt','r',encoding='utf-8') as f:

print(f.readlines())

['欢迎来到 Python 文件导入教程。我们会关注以下文件类型的处理:\n', '1. Text\n', '2. CSV\n', '3. Excel\n', '4. SQL\n', '5. Web 数据\n', '6. Image\n', '阅读愉快!']

这里 readlines() 方法将整个文本提取成了列表格式。

import pandas as pd

# 读取文件为 DataFrame

df = pd.read_csv(r'./data/demo data/Products.csv')

df

| ID | Product | Price | |

|---|---|---|---|

| 0 | 1 | Pen | 10 |

| 1 | 2 | Pencil | 5 |

| 2 | 3 | Eraser | 2 |

| 3 | 4 | Notebook | 40 |

| 4 | 5 | Stapler | 60 |

但数据值里包括逗号的话 CSV 文件就会遇到问题。这可以靠采用不同分隔符解决,比如 \t 或 ; 等:

import pandas as pd

df = pd.read_csv(r'./data/demo data/Employee.txt',delimiter='\t')

df

| ID,Name,Job | |

|---|---|

| 0 | 1,Tom,Full Stack |

| 1 | 2,Jerry,Frontend |

| 2 | 3,Merry,Backend |

| 3 | 4,Jack,Data Science |

想必你对 Excel 文件不会陌生,谈到表格类数据必定少不了它。Pandas 提供了一个很方便的方法 read_excel() 读取 Excel 文件:

import pandas as pd

df = pd.read_excel(r'./data/demo data/World_city.xlsx')

df

| ID | City | Country | |

|---|---|---|---|

| 0 | 1 | Beijing | China |

| 1 | 2 | Tokyo | Japan |

| 2 | 3 | New Delhi | India |

| 3 | 4 | Seoul | South Koera |

但 Excel 文件通常有多个表单,此时可以用 Pandas 的 ExcelFile() 方法打印文件内所有表单名称:

# pandas 读取 Excel sheets

xls = pd.ExcelFile(r'./data/demo data/World_city.xlsx')

xls.sheet_names

['Asia', 'Europe', 'Africa']

这样我们就可以通过参数 sheet_name 借助 read_excel() 方法读取任意表单内的数据了:

# 读取欧洲表单

df = pd.read_excel(r'./data/demo data/World_city.xlsx', sheet_name='Europe')

df

| ID | City | Country | |

|---|---|---|---|

| 0 | 1 | London | Britain |

| 1 | 2 | Pairs | France |

| 2 | 3 | Berlin | Germany |

| 3 | 4 | Moscow | Russia |

实际项目中,免不了从项目数据库中提取数据(所以 SQL 还是得学滴)。数据在数据库中是以表格形式存储的,(一般)这些系统又名关系数据库管理系统(RDBMS),访问不同数据库需要不同的 PYthon 模块支持,比如 SQLite 需要 sqlite3,MySQL 需要 mysql-connector。

一般的数据访问步骤为:

connect() 创建一个数据库连接,需要传入要访问的数据库名。它会返回一个 Connection 对象cursor() 创建一个 cursor 对象,通过它实现操作数据的 SQL 指令execute() 方法执行 SQL 命令。检索数据会用到 SELECT 语句,并将查询存入一个对象fetchone() 读入一行,或是 fetchcall() 读取所有行一个好习惯是,即使只是读取数据,也用 commit() 方法将你的事务保存/提交。

from getpass import getpass

from mysql.connector import connect, Error

# 连接数据库

try:

db=connect(

host="localhost",

user=input("Enter username: "),

passwd=getpass("Enter password: "),

database="nba",

auth_plugin='mysql_native_password'

)

except Error as e:

print(e)

# 获取游标

cursor = db.cursor()

# 执行查询操作

cursor.execute("SELECT * FROM player LIMIT 10")

df = pd.DataFrame(cursor.fetchall())

db.commit()

df

Enter username: root Enter password: ········

| 0 | 1 | 2 | 3 | |

|---|---|---|---|---|

| 0 | 10001 | 1001 | 韦恩-艾灵顿 | 1.93 |

| 1 | 10002 | 1001 | 雷吉-杰克逊 | 1.91 |

| 2 | 10003 | 1001 | 安德烈-德拉蒙德 | 2.11 |

| 3 | 10004 | 1001 | 索恩-马克 | 2.16 |

| 4 | 10005 | 1001 | 布鲁斯-布朗 | 1.96 |

| 5 | 10006 | 1001 | 兰斯顿-加洛韦 | 1.88 |

| 6 | 10007 | 1001 | 格伦-罗宾逊三世 | 1.98 |

| 7 | 10008 | 1001 | 伊斯梅尔-史密斯 | 1.83 |

| 8 | 10009 | 1001 | 扎扎-帕楚里亚 | 2.11 |

| 9 | 10010 | 1001 | 乔恩-洛伊尔 | 2.08 |

team_id = int(input("team id: "))

height = float(input("height: "))

select_query ="""

SELECT player_id,player_name FROM player

WHERE team_id=%d AND height > %f;

""" % (team_id, height)

cursor.execute(select_query)

df = pd.DataFrame(cursor.fetchall())

db.commit()

df

team id: 1001 height: 1.96

| 0 | 1 | |

|---|---|---|

| 0 | 10003 | 安德烈-德拉蒙德 |

| 1 | 10004 | 索恩-马克 |

| 2 | 10007 | 格伦-罗宾逊三世 |

| 3 | 10009 | 扎扎-帕楚里亚 |

| 4 | 10010 | 乔恩-洛伊尔 |

| 5 | 10011 | 布雷克-格里芬 |

| 6 | 10012 | 雷吉-巴洛克 |

| 7 | 10014 | 斯坦利-约翰逊 |

| 8 | 10015 | 亨利-埃伦森 |

| 9 | 10018 | 斯维亚托斯拉夫-米凯卢克 |

# 关闭数据库

cursor.close()

db.close()

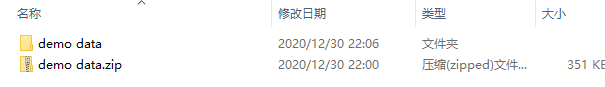

JSON (JavaScript Object Notation) 是用于数据存储、交换的轻量可读文件格式。机器很容易解析、生成这些文件。

JSON 中的数据用类似 Python 字典的方式存在 {} 中,JSON 是语言独立的,一般文件长这样:

Python 提供了 json 模块来读取 JSON 文件,像读文本一样简单。只不过这里的读方法变成了 json.load(),其返回一个 JSON 字典。

接着就可以用 pandas.DataFrame() 方法将其转换成 Pandas dataframe 格式了。

import json

with open(r'./data/demo data/sample_json.json','r') as file:

data = json.load(file)

print(type(data))

df_json = pd.DataFrame(data)

df_json

<class 'dict'>

| firstName | lastName | age | |

|---|---|---|---|

| 0 | Jane | Doe | 35 |

| 1 | Teddy | Dunken | 40 |

你甚至可以用 pandas.read_json() 直接将 JSON 文件读入 dataframe:

path = r'./data/demo data/sample_json.json'

df = pd.read_json(path)

df

| firstName | lastName | age | |

|---|---|---|---|

| 0 | Jane | Doe | 35 |

| 1 | Teddy | Dunken | 40 |

Pickle 文件常用于存储 Python 序列化对象,也就是说像 list,set,tuple,dict 这些在存入磁盘前先被转换成了字符流。这可以让你之后继续使用对象,当训练完模型想存起来之后预测用时,这就能派上用场了。

所以,如果存储前将文件序列化了,用之前就得先反序列化,这可以通过 pickle 模块的 pickle.load() 方法实现。在用 open() 打开 pickle 文件时候记得得用 rb 做参数,相应的,写入时记得用 wb。

import pickle

import pandas as pd

pickle_data = {'Name':['Tom','Jerry'],'Company':['Apple','Google'],

'Job':['Intern','Full time']}

with open(r'./data/demo data/sample_pickle.pkl','wb') as fw:

pickle.dump(pickle_data, fw)

with open(r'./data/demo data/sample_pickle.pkl','rb') as fo:

read_data = pickle.load(fo)

print(type(read_data))

df = pd.DataFrame(read_data)

df

<class 'dict'>

| Name | Company | Job | |

|---|---|---|---|

| 0 | Tom | Apple | Intern |

| 1 | Jerry | Full time |

网络爬虫就是从网络上抓取海量数据,这对要分析数据的数据科学家来讲很重要。

Python 提供了 requests 模块方便我们从网络获取数据。requests.get() 方法接收一个 URL 参数并返回相应的 HTML 结果。其工作流程可以概括为:

比如想了解北京市,从维基百科抓获的数据形式如下

import requests

web_resp = requests.get('https://zh.wikipedia.org/wiki/%E5%8C%97%E4%BA%AC%E5%B8%82')

# response 对象 text 属性,将网页 HTML 作为字符串返回

print(web_resp.text)

<!DOCTYPE html>

<html class="client-nojs" lang="zh" dir="ltr">

<head>

<meta charset="UTF-8"/>

<title>北京市 - 维基百科,自由的百科全书</title>

<script>document.documentElement.className="client-js";RLCONF={"wgBreakFrames":!1,"wgSeparatorTransformTable":["",""],"wgDigitTransformTable":["",""],"wgDefaultDateFormat":"zh","wgMonthNames":["","1月","2月","3月","4月","5月","6月","7月","8月","9月","10月","11月","12月"],"wgRequestId":"X-ld-wpAAL8AAvn2aXcAAACI","wgCSPNonce":!1,"wgCanonicalNamespace":"","wgCanonicalSpecialPageName":!1,"wgNamespaceNumber":0,"wgPageName":"北京市","wgTitle":"北京市","wgCurRevisionId":63604485,"wgRevisionId":63604485,"wgArticleId":463,"wgIsArticle":!0,"wgIsRedirect":!1,"wgAction":"view","wgUserName":null,"wgUserGroups":["*"],"wgCategories":["有参考文献错误的页面","CS1英语来源 (en)","CS1含有中文文本 (zh)","引文格式1错误:日期","含有访问日期但无网址的引用的页面","CS1俄语来源 (ru)","CS1美国英语来源 (en-us)","顶注重定向需要审阅的条目","维基数据存在坐标数据的页面","使用多个图像且自动缩放的页面",

"含有非中文內容的條目","嵌入hAudio微格式的條目","包含AAT标识符的维基百科条目","包含BNF标识符的维基百科条目","包含GND标识符的维基百科条目","包含ISNI标识符的维基百科条目","包含LCCN标识符的维基百科条目","包含NARA标识符的维基百科条目","包含NDL标识符的维基百科条目","包含NKC标识符的维基百科条目","包含NNL标识符的维基百科条目","包含VIAF标识符的维基百科条目","使用人口模板的頁面","中華人民共和國省級行政區","亞洲首都","国家园林城市","中華人民共和國直轄市","北京市","中国特大城市","国家历史文化名城","京津冀城市群","夏季奥林匹克运动会主办城市","亚洲运动会主办城市","中国历代国都","国家中心城市","国家经济中心城市"],"wgPageContentLanguage":"zh","wgPageContentModel":"wikitext","wgRelevantPageName":"北京市","wgRelevantArticleId":463,"wgUserVariant":"zh",

"wgIsProbablyEditable":!0,"wgRelevantPageIsProbablyEditable":!0,"wgRestrictionEdit":[],"wgRestrictionMove":[],"wgMediaViewerOnClick":!0,"wgMediaViewerEnabledByDefault":!0,"wgPopupsReferencePreviews":!1,"wgPopupsConflictsWithNavPopupGadget":!1,"wgPopupsConflictsWithRefTooltipsGadget":!0,"wgVisualEditor":{"pageLanguageCode":"zh","pageLanguageDir":"ltr","pageVariantFallbacks":["zh-hans","zh-hant","zh-cn","zh-tw","zh-hk","zh-sg","zh-mo","zh-my"]},"wgMFDisplayWikibaseDescriptions":{"search":!0,"nearby":!0,"watchlist":!0,"tagline":!0},"wgWMESchemaEditAttemptStepOversample":!1,"wgULSCurrentAutonym":"中文","wgNoticeProject":"wikipedia","wgCoordinates":{"lat":39.90555555555555,"lon":116.3913888888889},"wgCentralAuthMobileDomain":!1,"wgEditSubmitButtonLabelPublish":!0,"wgULSPosition":"interlanguage","wgWikibaseItemId":"Q956"};RLSTATE={"ext.gadget.large-font":"ready","ext.globalCssJs.user.styles":"ready","site.styles":"ready","noscript":"ready","user.styles":

"ready","ext.globalCssJs.user":"ready","user":"ready","user.options":"loading","ext.cite.styles":"ready","skins.vector.styles.legacy":"ready","jquery.tablesorter.styles":"ready","ext.visualEditor.desktopArticleTarget.noscript":"ready","ext.uls.interlanguage":"ready","ext.wikimediaBadges":"ready","wikibase.client.init":"ready"};RLPAGEMODULES=["ext.cite.ux-enhancements","site","mediawiki.page.ready","jquery.tablesorter","mediawiki.toc","skins.vector.legacy.js","ext.gadget.edit0","ext.gadget.Edittools-refToolbar","ext.gadget.WikiMiniAtlas","ext.gadget.ReferenceTooltips","ext.gadget.UnihanTooltips","ext.gadget.variant-link-fix","ext.gadget.FixedTopBottomLink","ext.gadget.confirm-logout","ext.gadget.shortURL","ext.gadget.Difflink","ext.gadget.AdvancedSiteNotices","ext.gadget.hideConversionTab","ext.gadget.internalLinkHelper-altcolor","ext.gadget.noteTA","ext.gadget.noteTAvector","ext.gadget.NavFrame","ext.gadget.collapsibleTables","ext.gadget.notifyConversion",

"ext.centralauth.centralautologin","mmv.head","mmv.bootstrap.autostart","ext.popups","ext.visualEditor.desktopArticleTarget.init","ext.visualEditor.targetLoader","ext.eventLogging","ext.wikimediaEvents","ext.navigationTiming","ext.uls.compactlinks","ext.uls.interface","ext.cx.eventlogging.campaigns","ext.centralNotice.geoIP","ext.centralNotice.startUp"];</script>

<script>(RLQ=window.RLQ||[]).push(function(){mw.loader.implement("user.options@1hzgi",function($,jQuery,require,module){/*@nomin*/mw.user.tokens.set({"patrolToken":"+\\","watchToken":"+\\","csrfToken":"+\\"});

});});</script>

<link rel="stylesheet" href="/w/load.php?lang=zh&modules=ext.cite.styles%7Cext.uls.interlanguage%7Cext.visualEditor.desktopArticleTarget.noscript%7Cext.wikimediaBadges%7Cjquery.tablesorter.styles%7Cskins.vector.styles.legacy%7Cwikibase.client.init&only=styles&skin=vector"/>

<script async="" src="/w/load.php?lang=zh&modules=startup&only=scripts&raw=1&skin=vector"></script>

<meta name="ResourceLoaderDynamicStyles" content=""/>

<link rel="stylesheet" href="/w/load.php?lang=zh&modules=ext.gadget.large-font&only=styles&skin=vector"/>

<link rel="stylesheet" href="/w/load.php?lang=zh&modules=site.styles&only=styles&skin=vector"/>

<meta name="generator" content="MediaWiki 1.36.0-wmf.25"/>

<meta name="referrer" content="origin"/>

<meta name="referrer" content="origin-when-crossorigin"/>

<meta name="referrer" content="origin-when-cross-origin"/>

<meta property="og:image" content="https://upload.wikimedia.org/wikipedia/commons/thumb/f/f2/Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg/1200px-Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg"/>

<link rel="preconnect" href="//upload.wikimedia.org"/>

<link rel="alternate" media="only screen and (max-width: 720px)" href="//zh.m.wikipedia.org/wiki/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" type="application/x-wiki" title="编辑本页" href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit"/>

<link rel="edit" title="编辑本页" href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit"/>

<link rel="apple-touch-icon" href="/static/apple-touch/wikipedia.png"/>

<link rel="shortcut icon" href="/static/favicon/wikipedia.ico"/>

<link rel="search" type="application/opensearchdescription+xml" href="/w/opensearch_desc.php" title="Wikipedia (zh)"/>

<link rel="EditURI" type="application/rsd+xml" href="//zh.wikipedia.org/w/api.php?action=rsd"/>

<link rel="alternate" hreflang="zh" href="/zh/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hans" href="/zh-hans/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hant" href="/zh-hant/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hans-CN" href="/zh-cn/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hant-HK" href="/zh-hk/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hant-MO" href="/zh-mo/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hans-MY" href="/zh-my/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hans-SG" href="/zh-sg/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="zh-Hant-TW" href="/zh-tw/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="alternate" hreflang="x-default" href="/wiki/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="license" href="//creativecommons.org/licenses/by-sa/3.0/"/>

<link rel="canonical" href="https://zh.wikipedia.org/wiki/%E5%8C%97%E4%BA%AC%E5%B8%82"/>

<link rel="dns-prefetch" href="//login.wikimedia.org"/>

<link rel="dns-prefetch" href="//meta.wikimedia.org" />

</head>

<body class="mediawiki ltr sitedir-ltr mw-hide-empty-elt ns-0 ns-subject mw-editable page-北京市 rootpage-北京市 skin-vector action-view skin-vector-legacy"><div id="mw-page-base" class="noprint"></div>

<div id="mw-head-base" class="noprint"></div>

<div id="content" class="mw-body" role="main">

<a id="top"></a>

<div id="siteNotice" class="mw-body-content"><!-- CentralNotice --></div>

<div class="mw-indicators mw-body-content">

<div id="mw-indicator-noteTA-d455684c" class="mw-indicator"><img alt="本页使用了标题或全文手工转换" src="//upload.wikimedia.org/wikipedia/commons/thumb/c/cd/Zh_conversion_icon_m.svg/35px-Zh_conversion_icon_m.svg.png" decoding="async" title="本页使用了标题或全文手工转换" width="35" height="22" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/c/cd/Zh_conversion_icon_m.svg/53px-Zh_conversion_icon_m.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/c/cd/Zh_conversion_icon_m.svg/70px-Zh_conversion_icon_m.svg.png 2x" data-file-width="32" data-file-height="20" /></div>

</div>

<h1 id="firstHeading" class="firstHeading" lang="zh">北京市</h1>

<div id="bodyContent" class="mw-body-content">

<div id="siteSub" class="noprint">维基百科,自由的百科全书</div>

<div id="contentSub"></div>

<div id="contentSub2"></div>

<div id="jump-to-nav"></div>

<a class="mw-jump-link" href="#mw-head">跳到导航</a>

<a class="mw-jump-link" href="#searchInput">跳到搜索</a>

<div id="mw-content-text" lang="zh" dir="ltr" class="mw-content-ltr"><div class="mw-parser-output"><div id="noteTA-d455684c" class="noteTA"><div class="noteTA-group"><div data-noteta-group-source="module" data-noteta-group="地名"></div></div><div class="noteTA-local"><div data-noteta-code="zh-hans:丰台; zh-hant:豐臺;"></div><div data-noteta-code="zh-hant:衚衕; zh-hans:胡同;"></div><div data-noteta-code="zh-hans:哈瓦那;zh-tw:哈瓦那;zh-hk:夏灣拿;zh-cn:哈瓦那;"></div></div></div>

<div role="note" class="hatnote navigation-not-searchable"><a href="/wiki/Wikipedia:%E6%B6%88%E6%AD%A7%E4%B9%89" title="Wikipedia:消歧义"><img alt="Disambig gray.svg" src="//upload.wikimedia.org/wikipedia/commons/thumb/5/5f/Disambig_gray.svg/25px-Disambig_gray.svg.png" decoding="async" width="25" height="19" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/5/5f/Disambig_gray.svg/38px-Disambig_gray.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/5/5f/Disambig_gray.svg/50px-Disambig_gray.svg.png 2x" data-file-width="220" data-file-height="168" /></a>  「<b>北平</b>」重定向至此。关于其他用法,请见「<b><a href="/wiki/%E5%8C%97%E5%B9%B3_(%E6%B6%88%E6%AD%A7%E7%BE%A9)" title="北平 (消歧義)">北平 (消歧义)</a></b>」。</div>

<p><span style="font-size: small;"><span id="coordinates"><a href="/wiki/%E5%9C%B0%E7%90%86%E5%9D%90%E6%A0%87" class="mw-redirect" title="地理坐标">坐标</a>:<span class="plainlinks nourlexpansion"><a class="external text" href="//tools.wmflabs.org/geohack/geohack.php?language=zh&pagename=%E5%8C%97%E4%BA%AC%E5%B8%82&params=39_54_20_N_116_23_29_E_region:CN-11_type:adm1st&title=%E5%8C%97%E4%BA%AC%E5%B8%82"><span class="geo-default"><span class="geo-dms" title="此地的地图、航拍照片和其他数据"><span class="latitude">39°54′20″N</span> <span class="longitude">116°23′29″E</span></span></span><span class="geo-multi-punct"> / </span><span class="geo-nondefault"><span class="vcard"><span class="geo-dec" title="此地的地图、航拍照片和其他数据">39.90556°N 116.39139°E</span><span style="display:none"> / <span class="geo">39.90556; 116.39139</span></span><span style="display:none"> (<span class="fn org">北京市</span>)</span></span></span></a></span></span></span>

</p>

<table class="infobox geography vcard" style="width:23em; font-size:85%;">

<tbody><tr>

<td colspan="2" class="mergedtoprow" style="line-height:1.25em; text-align:center;font-size:1.3em;"><b>北京市</b>

</td></tr>

<tr>

<td colspan="2" style="background-color:#cddeff; font-weight:bold; text-align:center;"><span class="nowrap"><b><a href="/wiki/%E7%9B%B4%E8%BE%96%E5%B8%82" title="直辖市">直辖市</a></b></span>

</td></tr>

<tr>

<td colspan="2" style="text-align:center;"><style data-mw-deduplicate="TemplateStyles:r61200722/mw-parser-output/.tmulti">.mw-parser-output .tmulti .thumbinner{display:flex;flex-direction:column}.mw-parser-output .tmulti .trow{display:flex;flex-direction:row;clear:left;flex-wrap:wrap;width:100%;box-sizing:border-box}.mw-parser-output .tmulti .tsingle{margin:1px;float:left}.mw-parser-output .tmulti .theader{clear:both;font-weight:bold;text-align:center;align-self:center;background-color:transparent;width:100%}.mw-parser-output .tmulti .thumbcaption{text-align:left;background-color:transparent}.mw-parser-output .tmulti .text-align-left{text-align:left}.mw-parser-output .tmulti .text-align-right{text-align:right}.mw-parser-output .tmulti .text-align-center{text-align:center}@media all and (max-width:720px){.mw-parser-output .tmulti .thumbinner{width:100%!important;box-sizing:border-box;max-width:none!important;align-items:center}.mw-parser-output .tmulti .trow{justify-content:center}.mw-parser-output .tmulti .tsingle{float:none!important;max-width:100%!important;box-sizing:border-box;text-align:center}.mw-parser-output .tmulti .thumbcaption{text-align:center}}</style><div class="thumb tmulti tnone center"><div class="thumbinner" style="width:272px;max-width:272px;border:none"><div class="trow"><div class="tsingle" style="width:270px;max-width:270px"><div class="thumbimage" style="border:1;;height:120px;overflow:hidden"><a href="/wiki/File:Beijing_skyline_from_northeast_4th_ring_road.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/6/64/Beijing_skyline_from_northeast_4th_ring_road.jpg/268px-Beijing_skyline_from_northeast_4th_ring_road.jpg" decoding="async" width="268" height="121" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/6/64/Beijing_skyline_from_northeast_4th_ring_road.jpg/402px-Beijing_skyline_from_northeast_4th_ring_road.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/6/64/Beijing_skyline_from_northeast_4th_ring_road.jpg/536px-Beijing_skyline_from_northeast_4th_ring_road.jpg 2x" data-file-width="7091" data-file-height="3190" /></a></div></div></div><div class="trow"><div class="tsingle" style="width:178px;max-width:178px"><div class="thumbimage" style="border:1;;height:132px;overflow:hidden"><a href="/wiki/File:Flickr_-_archer10_(Dennis)_-_China-6123.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/f/f2/Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg/176px-Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg" decoding="async" width="176" height="132" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/f/f2/Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg/264px-Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/f/f2/Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg/352px-Flickr_-_archer10_%28Dennis%29_-_China-6123.jpg 2x" data-file-width="3264" data-file-height="2448" /></a></div></div><div class="tsingle" style="width:90px;max-width:90px"><div class="thumbimage" style="border:1;;height:132px;overflow:hidden"><a href="/wiki/File:The_Great_Wall_of_China_-_Badaling.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/1/1b/The_Great_Wall_of_China_-_Badaling.jpg/88px-The_Great_Wall_of_China_-_Badaling.jpg" decoding="async" width="88" height="132" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/1/1b/The_Great_Wall_of_China_-_Badaling.jpg/132px-The_Great_Wall_of_China_-_Badaling.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/1/1b/The_Great_Wall_of_China_-_Badaling.jpg/176px-The_Great_Wall_of_China_-_Badaling.jpg 2x" data-file-width="2048" data-file-height="3072" /></a></div></div></div><div class="trow"><div class="tsingle" style="width:97px;max-width:97px"><div class="thumbimage" style="border:1;;height:95px;overflow:hidden"><a href="/wiki/File:TempleofHeaven-HallofPrayer_(square).jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/6/69/TempleofHeaven-HallofPrayer_%28square%29.jpg/95px-TempleofHeaven-HallofPrayer_%28square%29.jpg" decoding="async" width="95" height="95" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/6/69/TempleofHeaven-HallofPrayer_%28square%29.jpg/143px-TempleofHeaven-HallofPrayer_%28square%29.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/6/69/TempleofHeaven-HallofPrayer_%28square%29.jpg/190px-TempleofHeaven-HallofPrayer_%28square%29.jpg 2x" data-file-width="1303" data-file-height="1303" /></a></div></div><div class="tsingle" style="width:171px;max-width:171px"><div class="thumbimage" style="border:1;;height:95px;overflow:hidden"><a href="/wiki/File:Hall_of_Supreme_Harmony,_Forbidden_City,_from_southeast.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/4/4d/Hall_of_Supreme_Harmony%2C_Forbidden_City%2C_from_southeast.jpg/169px-Hall_of_Supreme_Harmony%2C_Forbidden_City%2C_from_southeast.jpg" decoding="async" width="169" height="95" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/4/4d/Hall_of_Supreme_Harmony%2C_Forbidden_City%2C_from_southeast.jpg/254px-Hall_of_Supreme_Harmony%2C_Forbidden_City%2C_from_southeast.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/4/4d/Hall_of_Supreme_Harmony%2C_Forbidden_City%2C_from_southeast.jpg/338px-Hall_of_Supreme_Harmony%2C_Forbidden_City%2C_from_southeast.jpg 2x" data-file-width="6048" data-file-height="3402" /></a></div></div></div><div class="trow"><div class="tsingle" style="width:136px;max-width:136px"><div class="thumbimage" style="border:1;;height:86px;overflow:hidden"><a href="/wiki/File:Beijing_National_Stadium_1.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/e/e0/Beijing_National_Stadium_1.jpg/134px-Beijing_National_Stadium_1.jpg" decoding="async" width="134" height="87" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/e/e0/Beijing_National_Stadium_1.jpg/201px-Beijing_National_Stadium_1.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/e/e0/Beijing_National_Stadium_1.jpg/268px-Beijing_National_Stadium_1.jpg 2x" data-file-width="1024" data-file-height="662" /></a></div></div><div class="tsingle" style="width:132px;max-width:132px"><div class="thumbimage" style="border:1;;height:86px;overflow:hidden"><a href="/wiki/File:%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/e/ee/%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg/130px-%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg" decoding="async" width="130" height="87" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/e/ee/%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg/195px-%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/e/ee/%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg/260px-%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C%E5%8D%97%E5%8C%BA.jpg 2x" data-file-width="4252" data-file-height="2835" /></a></div></div></div><div class="trow"><div class="tsingle" style="width:270px;max-width:270px"><div class="thumbimage" style="border:1;;height:123px;overflow:hidden"><a href="/wiki/File:National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/a/a5/National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg/268px-National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg" decoding="async" width="268" height="124" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/a/a5/National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg/402px-National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/a/a5/National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg/536px-National_Centre_for_the_Performing_Arts_and_Great_Hall_of_the_People.jpg 2x" data-file-width="1620" data-file-height="747" /></a></div></div></div></div></div>北京市风光(顺时针方向):<br /><a href="/wiki/%E5%8C%97%E4%BA%AC%E5%95%86%E5%8A%A1%E4%B8%AD%E5%BF%83%E5%8C%BA" title="北京商务中心区">北京CBD</a>天际线、<a href="/wiki/%E5%85%AB%E8%BE%BE%E5%B2%AD%E9%95%BF%E5%9F%8E" class="mw-redirect" title="八达岭长城">八達嶺長城</a>、<a href="/wiki/%E5%8C%97%E4%BA%AC%E6%95%85%E5%AE%AE" class="mw-redirect" title="北京故宮">北京故宮</a><a href="/wiki/%E5%A4%AA%E5%92%8C%E6%AE%BF" title="太和殿">太和殿</a>、<a href="/wiki/%E4%B8%89%E9%87%8C%E5%B1%AF%E5%A4%AA%E5%8F%A4%E9%87%8C" title="三里屯太古里">三里屯太古里</a>、<a href="/wiki/%E4%BA%BA%E6%B0%91%E5%A4%A7%E6%9C%83%E5%A0%82" class="mw-redirect" title="人民大會堂">人民大會堂</a>(左)與<a href="/wiki/%E5%9B%BD%E5%AE%B6%E5%A4%A7%E5%89%A7%E9%99%A2" title="国家大剧院">国家大剧院</a>(右)夜景、<a href="/wiki/%E5%9B%BD%E5%AE%B6%E4%BD%93%E8%82%B2%E5%9C%BA_(%E5%8C%97%E4%BA%AC)" title="国家体育场 (北京)">国家体育场</a>、<a href="/wiki/%E5%A4%A9%E5%9D%9B" title="天坛">天坛</a>祈年殿、<a href="/wiki/%E5%A4%A9%E5%AE%89%E9%97%A8%E5%9F%8E%E6%A5%BC" class="mw-redirect" title="天安门城楼">天安门城楼</a>

</td></tr>

<tr>

<td colspan="2" style="text-align:center;"><a href="/wiki/File:Beijing_in_China_(%2Ball_claims_hatched).svg" class="image" title="图中高亮显示的是北京市"><img alt="图中高亮显示的是北京市" src="//upload.wikimedia.org/wikipedia/commons/thumb/0/0e/Beijing_in_China_%28%2Ball_claims_hatched%29.svg/300px-Beijing_in_China_%28%2Ball_claims_hatched%29.svg.png" decoding="async" width="300" height="239" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/0/0e/Beijing_in_China_%28%2Ball_claims_hatched%29.svg/450px-Beijing_in_China_%28%2Ball_claims_hatched%29.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/0/0e/Beijing_in_China_%28%2Ball_claims_hatched%29.svg/600px-Beijing_in_China_%28%2Ball_claims_hatched%29.svg.png 2x" data-file-width="1181" data-file-height="940" /></a>

</td></tr>

<tr>

<td style="width:38%;"><b>简称</b></td>

<td><b>京</b></td></tr>

<tr style="display:none">

<td style="width:38%;"><b>名称起源</b></td>

<td></td></tr>

<tr>

<td style="width:38%;"><b>国家</b></td>

<td><span class="flagicon"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/f/fa/Flag_of_the_People%27s_Republic_of_China.svg/22px-Flag_of_the_People%27s_Republic_of_China.svg.png" decoding="async" width="22" height="15" class="thumbborder" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/f/fa/Flag_of_the_People%27s_Republic_of_China.svg/33px-Flag_of_the_People%27s_Republic_of_China.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/f/fa/Flag_of_the_People%27s_Republic_of_China.svg/44px-Flag_of_the_People%27s_Republic_of_China.svg.png 2x" data-file-width="900" data-file-height="600" /> </span><a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD" title="中华人民共和国">中华人民共和国</a></td></tr>

<tr><td><b>政府所在地</b></td>

<td><a href="/wiki/%E9%80%9A%E5%B7%9E%E5%8C%BA_(%E5%8C%97%E4%BA%AC%E5%B8%82)" title="通州区 (北京市)">通州区</a></td></tr> <tr><td><b>最大区县</b></td><td><a href="/wiki/%E5%AF%86%E4%BA%91%E5%8C%BA" title="密云区">密云区</a></td></tr>

<tr>

<td><b>主要领导人</b>

</td>

<td>

</td></tr>

<tr class="mergedrow">

<td>-<span class="nowrap"><a href="/wiki/%E5%B8%82%E5%A7%94%E4%B9%A6%E8%AE%B0" class="mw-redirect" title="市委书记">市委书记</a></span>

</td>

<td><a href="/wiki/%E8%94%A1%E5%A5%87" title="蔡奇">蔡奇</a>

</td></tr>

<tr class="mergedrow">

<td><span class="nowrap">-<a href="/wiki/%E4%BA%BA%E5%A4%A7%E5%B8%B8%E5%A7%94%E4%BC%9A" class="mw-redirect" title="人大常委会">人大常委会</a>主任</span>

</td>

<td><a href="/wiki/%E6%9D%8E%E4%BC%9F_(%E5%8C%97%E4%BA%AC%E5%B8%82%E5%A7%94%E5%B8%B8%E5%A7%94)" class="mw-redirect" title="李伟 (北京市委常委)">李偉</a>

</td></tr>

<tr class="mergedrow">

<td>-<span class="nowrap"><a href="/wiki/%E5%B8%82%E9%95%BF" title="市长">市长</a></span>

</td>

<td><a href="/wiki/%E9%99%88%E5%90%89%E5%AE%81" title="陈吉宁">陈吉宁</a>

</td></tr>

<tr class="mergedbottomrow">

<td>-<span class="nowrap"><a href="/wiki/%E6%94%BF%E5%8D%8F" class="mw-redirect" title="政协">政协</a>主席</span>

</td>

<td><a href="/wiki/%E5%90%89%E6%9E%97_(%E4%BA%BA%E7%89%A9)" title="吉林 (人物)">吉林</a>

</td></tr>

<tr>

<td><b><a href="/wiki/%E9%9D%A2%E7%A7%AF" title="面积">面积</a></b>

</td>

<td>16,411 km²(<a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E5%90%84%E7%9C%81%E7%BA%A7%E8%A1%8C%E6%94%BF%E5%8C%BA%E9%9D%A2%E7%A7%AF%E5%88%97%E8%A1%A8" class="mw-redirect" title="中华人民共和国各省级行政区面积列表">第29位</a>)

</td></tr>

<tr class="mergedrow">

<td>-占全国

</td>

<td>0.174%

</td></tr>

<tr class="mergedbottomrow" style="display:none">

<td>-占水域

</td>

<td>%

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%BA%BA%E5%8F%A3" title="人口">人口</a></b><sub>(2019)</sub>

</td>

<td>2153.6万<br />

<p>-城镇 1865万<sup id="cite_ref-1" class="reference"><a href="#cite_note-1">[1]</a></sup><br />

-市区 1123.6万<sup id="cite_ref-2" class="reference"><a href="#cite_note-2">[2]</a></sup><span id="noteTag-cite_ref-sup"><sup id="cite_ref-3" class="reference"><a href="#cite_note-3">[註 1]</a></sup></span>

</p>

</td></tr>

<tr class="mergedrow" style="display:none">

<td>-<a href="/wiki/%E4%BA%BA%E5%8F%A3%E5%AF%86%E5%BA%A6" title="人口密度">密度</a>

</td>

<td>/km²

</td></tr>

<tr class="mergedbottomrow" style="display:none">

<td>-占全国

</td>

<td>%

</td></tr>

<tr style="display:none">

<td><b><a href="/wiki/%E6%80%BB%E5%92%8C%E7%94%9F%E8%82%B2%E7%8E%87" title="总和生育率">总和生育率</a></b><sub>(2010)</sub>

</td>

<td>(<a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E5%90%84%E7%9C%81%E7%BA%A7%E8%A1%8C%E6%94%BF%E5%8C%BA%E6%80%BB%E5%92%8C%E7%94%9F%E8%82%B2%E7%8E%87%E8%A1%A8" title="中华人民共和国各省级行政区总和生育率表">第位</a>)

</td></tr>

<tr>

<td><b><a href="/wiki/%E6%96%B9%E8%A8%80" title="方言">方言</a></b>

</td>

<td><a href="/wiki/%E5%8C%97%E4%BA%AC%E8%AF%9D" title="北京话">北京话</a>

</td></tr>

<tr>

<td><b><a href="/wiki/%E5%9B%BD%E5%86%85%E7%94%9F%E4%BA%A7%E6%80%BB%E5%80%BC" title="国内生产总值">GDP</a></b><sub>(2019)</sub>

</td>

<td><a href="/wiki/%E4%BA%BA%E6%B0%91%E5%B8%81" title="人民币">¥</a>35371.3亿人民币<a href="/wiki/%E4%BA%BA%E6%B0%91%E5%B8%81" title="人民币">元</a><sup id="cite_ref-4" class="reference"><a href="#cite_note-4">[3]</a></sup><br />约合5350亿<span style="white-space: nowrap">美元</span>

</td></tr>

<tr class="mergedrow">

<td>-<a href="/wiki/%E4%BA%BA%E5%9D%87%E5%9B%BD%E5%86%85%E7%94%9F%E4%BA%A7%E6%80%BB%E5%80%BC" class="mw-redirect" title="人均国内生产总值">人均</a>

</td>

<td>¥16.4万人民币<a href="/wiki/%E4%BA%BA%E6%B0%91%E5%B8%81" title="人民币">元</a><br />约合24800<span style="white-space: nowrap">美元</span>

</td></tr>

<tr class="mergedbottomrow" style="display:none">

<td>-占全国

</td>

<td><a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E7%9C%81%E7%BA%A7%E8%A1%8C%E6%94%BF%E5%8C%BA%E5%9C%B0%E5%8C%BA%E7%94%9F%E4%BA%A7%E6%80%BB%E5%80%BC%E5%88%97%E8%A1%A8" title="中华人民共和国省级行政区地区生产总值列表">%</a>

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%BA%BA%E7%B1%BB%E5%8F%91%E5%B1%95%E6%8C%87%E6%95%B0" title="人类发展指数">HDI</a></b><sub>(2017)</sub>

</td>

<td>0.887(<span style="background:#007F00;color:#FFFFFF;"> 极高 </span>,<a href="/wiki/%E4%B8%AD%E5%9B%BD%E7%9C%81%E7%BA%A7%E8%A1%8C%E6%94%BF%E5%8C%BA%E4%BA%BA%E7%B1%BB%E5%8F%91%E5%B1%95%E6%8C%87%E6%95%B0%E5%88%97%E8%A1%A8" class="mw-redirect" title="中国省级行政区人类发展指数列表">第1位</a>)

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%B8%AD%E5%9C%8B%E6%B0%91%E6%97%8F%E5%88%97%E8%A1%A8" title="中國民族列表">主要民族</a></b></td>

<td><a href="/wiki/%E6%B1%89%E6%97%8F" title="汉族">汉族</a> 96%<br /><a href="/wiki/%E6%BB%A1%E6%97%8F" title="满族">满族</a> 2%<br /><a href="/wiki/%E5%9B%9E%E6%97%8F" title="回族">回族</a> 1.6%<br /><a href="/wiki/%E8%92%99%E5%8F%A4%E6%97%8F" title="蒙古族">蒙古族</a> 0.3%

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E5%A2%83%E5%86%85%E5%9C%B0%E5%8C%BA%E9%82%AE%E6%94%BF%E7%BC%96%E7%A0%81%E5%88%97%E8%A1%A8" title="中华人民共和国境内地区邮政编码列表">邮政编码</a></b></td>

<td>100000

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E7%94%B5%E8%AF%9D%E5%8C%BA%E5%8F%B7" class="mw-redirect" title="中华人民共和国电话区号">电话区号</a></b></td>

<td><a href="/wiki/%E5%9B%BD%E9%99%85%E5%86%A0%E7%A0%81" class="mw-redirect" title="国际冠码">+</a><a href="/wiki/%E5%9B%BD%E9%99%85%E7%94%B5%E8%AF%9D%E5%8C%BA%E5%8F%B7%E5%88%97%E8%A1%A8" title="国际电话区号列表">86</a><a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E7%94%B5%E8%AF%9D%E5%8C%BA%E5%8F%B7" class="mw-redirect" title="中华人民共和国电话区号">(0)10</a>

</td></tr>

<tr>

<td><b><a href="/wiki/%E5%B8%82%E6%A0%91" title="市树">市树</a></b></td>

<td><a href="/wiki/%E4%BE%A7%E6%9F%8F" title="侧柏">侧柏</a>、<a href="/wiki/%E5%9B%BD%E6%A7%90" class="mw-redirect" title="国槐">国槐</a>

</td></tr>

<tr>

<td><b><a href="/wiki/%E5%B8%82%E8%8A%B1" title="市花">市花</a></b></td>

<td><a href="/wiki/%E6%9C%88%E5%AD%A3" title="月季">月季</a>、<a href="/wiki/%E8%8F%8A%E8%8A%B1" title="菊花">菊花</a>

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD%E8%BD%A6%E8%BE%86%E7%89%8C%E7%85%A7" class="mw-redirect" title="中华人民共和国车辆牌照">车辆号牌</a></b></td>

<td>京A, C, E, F, H, J, K, L, M, N, P, Q<br />京B(出租车)<br />京G,Y(郊区)<br />京O,D(警察和政府)

</td></tr>

<tr>

<td><b><a href="/wiki/%E5%8E%BF%E7%BA%A7%E8%A1%8C%E6%94%BF%E5%8C%BA" title="县级行政区">县级行政区</a></b>

</td>

<td>16个

</td></tr>

<tr>

<td><b><a href="/wiki/%E4%B9%A1%E7%BA%A7%E8%A1%8C%E6%94%BF%E5%8C%BA" title="乡级行政区">乡级行政区</a></b>

</td>

<td>322个

</td></tr>

<tr>

<td><b><a href="/wiki/ISO_3166-2" title="ISO 3166-2">ISO 3166-2</a></b></td>

<td>CN-BJ

</td></tr>

<tr>

<td colspan="2" style="text-align:center;"><b>政府门户网站</b><br /><a rel="nofollow" class="external text" href="http://www.beijing.gov.cn/">首都之窗</a>

</td></tr>

<tr>

<td colspan="2"><span style="font-size:smaller;"><b>人口与GDP数据的参考文献:</b></span><div style="padding-left:2em;"><small><div>

<ul><li>2010年2月26日,中国之声《央广新闻》14时15分报道</li></ul></div></small></div><span style="font-size:smaller;"><b>民族数据的参考文献:</b></span><div style="padding-left:2em;"><small><div>

<li>2010年8月20日,新华网-新华新闻报道</li></div></small>

</div></td></tr></tbody></table>

<table class="infobox" style="width: 22em; text-align:left; font-size:small; line-height:1.5em;"><tbody><tr><td colspan="2" style="text-align:center;font-size: 125%; background-color: #b0c4de;"><b>北京市</b></td></tr><tr><th scope="row" style="text-align:left;font-weight:normal; white-space: nowrap; font-size: small;"><a href="/wiki/%E6%B1%89%E8%AF%AD" title="汉语">汉语</a></th><td style="font-size: small; width: 50%;;"><span style="font-size: 1rem; width: 50%;"><span lang="zh-hani"> 北京 </span></span></td></tr><tr><td colspan="2" style="text-align:center;font-size: small; width: 50%;;"></td></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;"><a href="/wiki/%E6%B1%89%E8%AF%AD%E6%8B%BC%E9%9F%B3" title="汉语拼音">汉语拼音</a></th><td style="width: 50%; text-align: left;"><style data-mw-deduplicate="TemplateStyles:r58929728">.mw-parser-output .sans-serif{font-family:-apple-system,BlinkMacSystemFont,"Segoe UI",Roboto,Lato,"Helvetica Neue",Helvetica,Arial,sans-serif}</style><span class="sans-serif"> Běijīng<br /><span class="unicode haudio"><span class="fn"><span style="white-space:nowrap"><a href="/wiki/File:Zh-Beijing.ogg" title="关于这个音频文件"><img alt="关于这个音频文件" src="//upload.wikimedia.org/wikipedia/commons/thumb/8/8a/Loudspeaker.svg/11px-Loudspeaker.svg.png" decoding="async" width="11" height="11" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/8/8a/Loudspeaker.svg/17px-Loudspeaker.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/8/8a/Loudspeaker.svg/22px-Loudspeaker.svg.png 2x" data-file-width="20" data-file-height="20" /></a> </span><a href="//upload.wikimedia.org/wikipedia/commons/8/8a/Zh-Beijing.ogg" class="internal" title="Zh-Beijing.ogg">发音</a></span><small class="metadata audiolinkinfo" style="cursor:help;"> <sup><a href="/wiki/Wikipedia:%E5%AA%92%E9%AB%94%E5%B9%AB%E5%8A%A9" class="mw-redirect" title="Wikipedia:媒體幫助"><span style="cursor:help;">帮助</span></a>·<a href="/wiki/File:Zh-Beijing.ogg" title="File:Zh-Beijing.ogg"><span style="cursor:help;">信息</span></a></sup></small></span> </span></td></tr><tr style="display:none"><td colspan="2">

</td></tr><tr><th scope="row" style="text-align:left;font-weight:normal; white-space: nowrap; font-size: small;"><a href="/wiki/%E9%83%B5%E6%94%BF%E5%BC%8F%E6%8B%BC%E9%9F%B3" title="郵政式拼音">郵政式拼音</a></th><td style="font-size: small; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> Peking </span></td></tr><tr><td colspan="2" style="text-align:center;font-size: small; width: 50%;;"><table class="collapsible collapsed" cellspacing="3" style="border-spacing:3px;padding:0;border:none;margin:-3px;width:auto;min-width:100%;font-size:small;clear:none;float:none;background-color:transparent"><tbody><tr><th colspan="2" style="text-align:center;font-size:125%;font-weight:bold;font-size: 100%; text-align: left; background-color: #f9ffbc">标音</th></tr><tr><th colspan="2" style="text-align:center;background-color: #dcffc9; font-size: small;"><a href="/wiki/%E5%AE%98%E8%AF%9D" title="官话">官话</a></th></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E6%B1%89%E8%AF%AD%E6%8B%BC%E9%9F%B3" title="汉语拼音">汉语拼音</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> Běijīng<br /><span class="unicode haudio"><span class="fn"><span style="white-space:nowrap"><a href="/wiki/File:Zh-Beijing.ogg" title="关于这个音频文件"><img alt="关于这个音频文件" src="//upload.wikimedia.org/wikipedia/commons/thumb/8/8a/Loudspeaker.svg/11px-Loudspeaker.svg.png" decoding="async" width="11" height="11" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/8/8a/Loudspeaker.svg/17px-Loudspeaker.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/8/8a/Loudspeaker.svg/22px-Loudspeaker.svg.png 2x" data-file-width="20" data-file-height="20" /></a> </span><a href="//upload.wikimedia.org/wikipedia/commons/8/8a/Zh-Beijing.ogg" class="internal" title="Zh-Beijing.ogg">发音</a></span><small class="metadata audiolinkinfo" style="cursor:help;"> <sup><a href="/wiki/Wikipedia:%E5%AA%92%E9%AB%94%E5%B9%AB%E5%8A%A9" class="mw-redirect" title="Wikipedia:媒體幫助"><span style="cursor:help;">帮助</span></a>·<a href="/wiki/File:Zh-Beijing.ogg" title="File:Zh-Beijing.ogg"><span style="cursor:help;">信息</span></a></sup></small></span> </span></td></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E5%A8%81%E5%A6%A5%E7%91%AA%E6%8B%BC%E9%9F%B3" title="威妥瑪拼音">威妥瑪拼音</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> Pei<sup>3</sup>ching<sup>1</sup> or Pei<sup>3</sup>-ching<sup>1</sup> </span></td></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E6%B3%A8%E9%9F%B3%E7%AC%A6%E8%99%9F" title="注音符號">注音符號</a></th><td style="text-align: left; width: 50%;;">ㄅㄟˇ ㄐㄧㄥ</td></tr><tr><th colspan="2" style="text-align:center;background-color: #dcffc9; font-size: small;"><a href="/wiki/%E5%AE%98%E8%AF%9D" title="官话">其他官话</a></th></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E5%8D%97%E4%BA%AC%E5%AE%98%E8%AF%9D" class="mw-redirect" title="南京官话">南京官话</a><a href="/wiki/%E5%8D%97%E4%BA%AC%E8%A9%B1%E6%8B%89%E4%B8%81%E5%8C%96%E6%96%B9%E6%A1%88#輸入法方案" title="南京話拉丁化方案">拼音</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> bä<sup>5</sup>jin<sup>1</sup> </span></td></tr><tr><th colspan="2" style="text-align:center;background-color: #dcffc9; font-size: small;"><a href="/wiki/%E9%97%BD%E8%AF%AD" title="闽语">闽语</a></th></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E9%97%BD%E5%8D%97%E8%AF%AD" title="闽南语">闽南语</a><a href="/wiki/%E7%99%BD%E8%A9%B1%E5%AD%97" title="白話字">白話字</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> Pak-kiaⁿ </span></td></tr><tr><th colspan="2" style="text-align:center;background-color: #dcffc9; font-size: small;"><a href="/wiki/%E5%90%B4%E8%AF%AD" title="吴语">吴语</a></th></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E5%90%B4%E8%AF%AD" title="吴语">拉丁化</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> poh<sup>入</sup>cin<sup>平</sup> </span></td></tr><tr><th colspan="2" style="text-align:center;background-color: #dcffc9; font-size: small;"><a href="/wiki/%E7%B2%A4%E8%AF%AD" title="粤语">粤语</a></th></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E7%B2%B5%E6%8B%BC" class="mw-redirect" title="粵拼">粵拼</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> bak<sup>1</sup>ging<sup>1</sup> </span></td></tr><tr><th colspan="2" style="text-align:center;background-color: #dcffc9; font-size: small;"><a href="/wiki/%E5%AE%A2%E5%AE%B6%E8%AF%9D" title="客家话">客家话</a></th></tr><tr><th scope="row" style="text-align:left;font-weight:normal; width: 50%; white-space: nowrap;">- <a href="/wiki/%E5%AE%A2%E5%AE%B6%E8%A9%B1%E6%8B%BC%E9%9F%B3%E6%96%B9%E6%A1%88" title="客家話拼音方案">客家话拼音</a></th><td style="text-align: left; width: 50%;;"><link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r58929728"/><span class="sans-serif"> Pet-kîn </span></td></tr></tbody></table></td></tr></tbody></table>

<p><b>北京市</b>,通称<b>北京</b>(<a href="/wiki/%E6%B1%89%E8%AF%AD%E6%8B%BC%E9%9F%B3" title="汉语拼音">汉语拼音</a>:<i>Běijīng</i>;<a href="/wiki/%E9%82%AE%E6%94%BF%E5%BC%8F%E6%8B%BC%E9%9F%B3" class="mw-redirect" title="邮政式拼音">邮政式拼音</a>:Peking),简称“<b>京</b>”,是<a href="/wiki/%E4%B8%AD%E8%8F%AF%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9C%8B" class="mw-redirect" title="中華人民共和國">中華人民共和國</a>的<a href="/wiki/%E9%A6%96%E9%83%BD" title="首都">首都</a>及<a href="/wiki/%E7%9B%B4%E8%BE%96%E5%B8%82" title="直辖市">直辖市</a>,是中國大陸的<a href="/wiki/%E6%94%BF%E6%B2%BB" title="政治">政治</a>、<a href="/wiki/%E6%96%87%E5%8C%96" title="文化">文化</a>、科技和国际交往中心,是<a href="/wiki/%E6%8C%89%E5%B8%82%E5%9F%9F%E4%BA%BA%E5%8F%A3%E6%8E%92%E5%88%97%E7%9A%84%E4%B8%96%E7%95%8C%E5%9F%8E%E5%B8%82%E5%88%97%E8%A1%A8" title="按市域人口排列的世界城市列表">世界人口第三多的城市</a>和<a href="/wiki/%E5%85%A8%E7%90%83%E9%A6%96%E9%83%BD%E4%BA%BA%E5%8F%A3%E6%8E%92%E5%90%8D" title="全球首都人口排名">人口最多的首都</a>,具有重要的国际影响力。北京位於<a href="/wiki/%E8%8F%AF%E5%8C%97%E5%B9%B3%E5%8E%9F" class="mw-redirect" title="華北平原">華北平原</a>的西北边缘,背靠<a href="/wiki/%E7%87%95%E5%B1%B1" title="燕山">燕山</a>,有<a href="/wiki/%E6%B0%B8%E5%AE%9A%E6%B2%B3" title="永定河">永定河</a>流经<a href="/wiki/%E5%8C%97%E4%BA%AC%E5%9F%8E%E6%B1%A0" class="mw-redirect" title="北京城池">老城</a>西南,毗邻<a href="/wiki/%E5%A4%A9%E6%B4%A5%E5%B8%82" title="天津市">天津市</a>、<a href="/wiki/%E6%B2%B3%E5%8C%97%E7%9C%81" title="河北省">河北省</a>,为<a href="/wiki/%E4%BA%AC%E6%B4%A5%E5%86%80%E5%9F%8E%E5%B8%82%E7%BE%A4" title="京津冀城市群">京津冀城市群</a>的重要组成部分。

</p><p>北京是中国<a href="/wiki/%E5%9B%9B%E5%A4%A7%E5%8F%A4%E9%83%BD" class="mw-redirect" title="四大古都">古都</a>之一,是拥有三千余年建城历史、八百六十余年建都史的<a href="/wiki/%E5%8E%86%E5%8F%B2%E6%96%87%E5%8C%96%E5%90%8D%E5%9F%8E" class="mw-redirect" title="历史文化名城">历史文化名城</a>,有<a href="/wiki/%E8%BE%BD%E6%9C%9D" title="辽朝">辽</a>、<a href="/wiki/%E9%87%91%E6%9C%9D" title="金朝">金</a>、<a href="/wiki/%E5%85%83%E6%9C%9D" title="元朝">元</a>、<a href="/wiki/%E6%98%8E%E6%9C%9D" title="明朝">明</a>、<a href="/wiki/%E6%B8%85" class="mw-redirect" title="清">清</a>五个<a href="/wiki/%E6%9C%9D%E4%BB%A3" title="朝代">朝代</a>在此定都,及数个政权建政于此。<a href="/wiki/%E7%89%A7%E9%87%8E%E4%B9%8B%E6%88%98" title="牧野之战">公元前1122年</a><a href="/wiki/%E5%91%A8%E6%AD%A6%E7%8E%8B" title="周武王">周武王</a>灭<a href="/wiki/%E5%95%86%E6%9C%9D" title="商朝">商</a>后,封宗室<a href="/wiki/%E5%8F%AC%E5%85%AC%E5%A5%AD" title="召公奭">召公奭</a>于<a href="/wiki/%E7%87%95%E5%9B%BD" title="燕国">燕国</a>,是为北京建城之始。金中都时期人口超过一百万,为元、明、清三代的北京城的建设奠定了基础。1949年,北京被定为<a href="/wiki/%E4%B8%AD%E5%8D%8E%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9B%BD" title="中华人民共和国">中华人民共和国</a>首都,此后曾发生了<a href="/wiki/%E7%BA%A2%E5%85%AB%E6%9C%88" title="红八月">红八月</a>、<a href="/wiki/%E5%9B%9B%E4%BA%94%E8%BF%90%E5%8A%A8" title="四五运动">四五运动</a>、<a href="/wiki/%E5%85%AD%E5%9B%9B%E5%A4%A9%E5%AE%89%E9%97%A8%E4%BA%8B%E4%BB%B6" class="mw-redirect" title="六四天安门事件">六四天安门事件</a>等各种重大事件。北京荟萃了自元明清以来的近世<a href="/wiki/%E4%B8%AD%E5%8D%8E%E6%96%87%E5%8C%96" title="中华文化">中华文化</a>,拥有众多历史名胜古迹和人文景观,拥有7项<a href="/wiki/%E4%B8%AD%E5%9B%BD%E4%B8%96%E7%95%8C%E9%81%97%E4%BA%A7" class="mw-redirect" title="中国世界遗产">世界遗产</a>,是世界上拥有<a href="/wiki/%E6%96%87%E5%8C%96%E9%81%97%E4%BA%A7" title="文化遗产">文化遗产</a>项目数最多的城市。在中国过去的八个世纪里,几乎北京所有的主要建筑都拥有不可磨灭的历史意义。北京古迹众多,著名的有<a href="/wiki/%E7%B4%AB%E7%A6%81%E5%9F%8E" class="mw-redirect" title="紫禁城">紫禁城</a>、<a href="/wiki/%E5%A4%A9%E5%9D%9B" title="天坛">天坛</a>、<a href="/wiki/%E9%A2%90%E5%92%8C%E5%9B%AD" title="颐和园">颐和园</a>、<a href="/wiki/%E5%9C%86%E6%98%8E%E5%9B%AD" title="圆明园">圆明园</a>、<a href="/wiki/%E5%8C%97%E6%B5%B7%E5%85%AC%E5%9B%AD" title="北海公园">北海公园</a>等;<a href="/wiki/%E8%83%A1%E5%90%8C" title="胡同">胡同</a>和<a href="/wiki/%E5%9B%9B%E5%90%88%E9%99%A2" title="四合院">四合院</a>作为北京老城的典型民居形式,已经是北京历史重要的文化符号<sup id="cite_ref-autogenerated2_5-0" class="reference"><a href="#cite_note-autogenerated2-5">[4]</a></sup>。北京是中国重要的旅游城镇之一,被《<a href="/wiki/%E7%B1%B3%E5%85%B6%E6%9E%97" title="米其林">米其林</a>旅游指南》评为“三星级旅游推荐”(最高级别)<sup id="cite_ref-6" class="reference"><a href="#cite_note-6">[5]</a></sup>。

</p><p>北京在中国大陸的政治、经贸、文化、教育和科技领域拥有显著影响力,为中国大陸绝大多数<a href="/wiki/%E5%9B%BD%E6%9C%89%E4%BC%81%E4%B8%9A" title="国有企业">国有企业</a>总部所在地,并且拥有全球最多的<a href="/wiki/%E8%B4%A2%E5%AF%8C%E4%B8%96%E7%95%8C500%E5%BC%BA" title="财富世界500强">财富世界500强</a>企业总部<sup id="cite_ref-7" class="reference"><a href="#cite_note-7">[6]</a></sup>,<a href="/wiki/%E5%8C%97%E4%BA%AC%E5%95%86%E5%8A%A1%E4%B8%AD%E5%BF%83%E5%8C%BA" title="北京商务中心区">北京商务中心区</a>聚集有大量国际性金融商务办公设施及<a href="/wiki/%E6%91%A9%E5%A4%A9%E5%A4%A7%E6%A5%BC" class="mw-redirect" title="摩天大楼">摩天大楼</a>,<a href="/wiki/%E4%B8%AD%E5%85%B3%E6%9D%91" title="中关村">中关村地区</a>则集中了中国大陸重要的高新技术产业。北京是<a href="/wiki/%E4%B8%AD%E8%8F%AF%E4%BA%BA%E6%B0%91%E5%85%B1%E5%92%8C%E5%9C%8B%E9%90%B5%E8%B7%AF%E9%81%8B%E8%BC%B8" title="中華人民共和國鐵路運輸">中国大陸铁路运输</a>和<a href="/wiki/%E4%B8%AD%E5%9B%BD%E5%85%AC%E8%B7%AF" class="mw-redirect" title="中国公路">公路运输</a>的枢纽城市之一,<a href="/wiki/%E5%8C%97%E4%BA%AC%E9%A6%96%E9%83%BD%E5%9B%BD%E9%99%85%E6%9C%BA%E5%9C%BA" title="北京首都国际机场">北京首都国际机场</a>的旅客吞吐量位居世界第二<sup id="cite_ref-2018年旅客破亿_8-0" class="reference"><a href="#cite_note-2018年旅客破亿-8">[7]</a></sup>,<a href="/wiki/%E5%8C%97%E4%BA%AC%E5%9C%B0%E9%93%81" title="北京地铁">北京地铁</a>则是世界上运营里程最长、客运量最多的<a href="/wiki/%E5%9F%8E%E5%B8%82%E8%BD%A8%E9%81%93%E4%BA%A4%E9%80%9A%E7%B3%BB%E7%BB%9F" class="mw-redirect" title="城市轨道交通系统">城市轨道交通系统</a><sup id="cite_ref-9" class="reference"><a href="#cite_note-9">[8]</a></sup><sup id="cite_ref-10" class="reference"><a href="#cite_note-10">[9]</a></sup><sup id="cite_ref-11" class="reference"><a href="#cite_note-11">[10]</a></sup>。北京是中国大陸拥有最多<a href="/wiki/%E9%AB%98%E7%AD%89%E9%99%A2%E6%A0%A1" class="mw-redirect" title="高等院校">高等院校</a>的城市<sup id="cite_ref-Beijing_12-0" class="reference"><a href="#cite_note-Beijing-12">[11]</a></sup>,校址位于北京的<a href="/wiki/%E6%B8%85%E5%8D%8E%E5%A4%A7%E5%AD%A6" title="清华大学">清华大学</a>和<a href="/wiki/%E5%8C%97%E4%BA%AC%E5%A4%A7%E5%AD%A6" title="北京大学">北京大学</a>被视为中国大陸顶尖大学的代表<sup id="cite_ref-13" class="reference"><a href="#cite_note-13">[12]</a></sup>。北京在全球政治、经济等社会活动中处于重要地位并具有主导辐射带动能力,在GaWC<a href="/wiki/%E5%85%A8%E7%90%83%E5%9F%8E%E5%B8%82" title="全球城市">全球城市</a>排行中排名第6,在中華人民共和国中,仅次于<a href="/wiki/%E9%A6%99%E6%B8%AF" title="香港">香港</a>和<a href="/wiki/%E4%B8%8A%E6%B5%B7" class="mw-redirect" title="上海">上海</a><sup id="cite_ref-14" class="reference"><a href="#cite_note-14">[13]</a></sup>。

</p>

<div id="toc" class="toc" role="navigation" aria-labelledby="mw-toc-heading"><input type="checkbox" role="button" id="toctogglecheckbox" class="toctogglecheckbox" style="display:none" /><div class="toctitle" lang="zh" dir="ltr"><h2 id="mw-toc-heading">目录</h2><span class="toctogglespan"><label class="toctogglelabel" for="toctogglecheckbox"></label></span></div>

<ul>

<li class="toclevel-1 tocsection-1"><a href="#名称"><span class="tocnumber">1</span> <span class="toctext">名称</span></a></li>

<li class="toclevel-1 tocsection-2"><a href="#历史"><span class="tocnumber">2</span> <span class="toctext">历史</span></a>

<ul>

<li class="toclevel-2 tocsection-3"><a href="#史前"><span class="tocnumber">2.1</span> <span class="toctext">史前</span></a></li>

<li class="toclevel-2 tocsection-4"><a href="#古代"><span class="tocnumber">2.2</span> <span class="toctext">古代</span></a></li>

<li class="toclevel-2 tocsection-5"><a href="#近代"><span class="tocnumber">2.3</span> <span class="toctext">近代</span></a></li>

<li class="toclevel-2 tocsection-6"><a href="#文化大革命期间"><span class="tocnumber">2.4</span> <span class="toctext">文化大革命期间</span></a></li>

<li class="toclevel-2 tocsection-7"><a href="#现当代"><span class="tocnumber">2.5</span> <span class="toctext">现当代</span></a></li>

</ul>

</li>

<li class="toclevel-1 tocsection-8"><a href="#地理"><span class="tocnumber">3</span> <span class="toctext">地理</span></a>

<ul>

<li class="toclevel-2 tocsection-9"><a href="#氣候"><span class="tocnumber">3.1</span> <span class="toctext">氣候</span></a></li>

<li class="toclevel-2 tocsection-10"><a href="#空气污染"><span class="tocnumber">3.2</span> <span class="toctext">空气污染</span></a></li>

</ul>

</li>

<li class="toclevel-1 tocsection-11"><a href="#行政区划"><span class="tocnumber">4</span> <span class="toctext">行政区划</span></a></li>

<li class="toclevel-1 tocsection-12"><a href="#政治"><span class="tocnumber">5</span> <span class="toctext">政治</span></a>

<ul>

<li class="toclevel-2 tocsection-13"><a href="#四大机构"><span class="tocnumber">5.1</span> <span class="toctext">四大机构</span></a></li>

</ul>

</li>

<li class="toclevel-1 tocsection-14"><a href="#经济"><span class="tocnumber">6</span> <span class="toctext">经济</span></a>

<ul>

<li class="toclevel-2 tocsection-15"><a href="#經濟數據"><span class="tocnumber">6.1</span> <span class="toctext">經濟數據</span></a></li>

<li class="toclevel-2 tocsection-16"><a href="#-{zh:基础设施;zh-hans:基础设施;zh-hant:基礎建設}-"><span class="tocnumber">6.2</span> <span class="toctext">基础设施</span></a>

<ul>

<li class="toclevel-3 tocsection-17"><a href="#公路"><span class="tocnumber">6.2.1</span> <span class="toctext">公路</span></a></li>

<li class="toclevel-3 tocsection-18"><a href="#铁路"><span class="tocnumber">6.2.2</span> <span class="toctext">铁路</span></a></li>

<li class="toclevel-3 tocsection-19"><a href="#航空"><span class="tocnumber">6.2.3</span> <span class="toctext">航空</span></a></li>

<li class="toclevel-3 tocsection-20"><a href="#地面公交"><span class="tocnumber">6.2.4</span> <span class="toctext">地面公交</span></a></li>

<li class="toclevel-3 tocsection-21"><a href="#出租车"><span class="tocnumber">6.2.5</span> <span class="toctext">出租车</span></a></li>

<li class="toclevel-3 tocsection-22"><a href="#邮电"><span class="tocnumber">6.2.6</span> <span class="toctext">邮电</span></a></li>

</ul>

</li>

<li class="toclevel-2 tocsection-23"><a href="#旅游業"><span class="tocnumber">6.3</span> <span class="toctext">旅游業</span></a></li>

</ul>

</li>

<li class="toclevel-1 tocsection-24"><a href="#教育"><span class="tocnumber">7</span> <span class="toctext">教育</span></a></li>

<li class="toclevel-1 tocsection-25"><a href="#人口"><span class="tocnumber">8</span> <span class="toctext">人口</span></a></li>

<li class="toclevel-1 tocsection-26"><a href="#文化"><span class="tocnumber">9</span> <span class="toctext">文化</span></a>

<ul>

<li class="toclevel-2 tocsection-27"><a href="#文学"><span class="tocnumber">9.1</span> <span class="toctext">文学</span></a></li>

<li class="toclevel-2 tocsection-28"><a href="#饮食文化"><span class="tocnumber">9.2</span> <span class="toctext">饮食文化</span></a></li>

<li class="toclevel-2 tocsection-29"><a href="#表演艺术"><span class="tocnumber">9.3</span> <span class="toctext">表演艺术</span></a></li>

<li class="toclevel-2 tocsection-30"><a href="#艺术园区"><span class="tocnumber">9.4</span> <span class="toctext">艺术园区</span></a></li>

</ul>

</li>

<li class="toclevel-1 tocsection-31"><a href="#人物"><span class="tocnumber">10</span> <span class="toctext">人物</span></a></li>

<li class="toclevel-1 tocsection-32"><a href="#宗教"><span class="tocnumber">11</span> <span class="toctext">宗教</span></a></li>

<li class="toclevel-1 tocsection-33"><a href="#体育"><span class="tocnumber">12</span> <span class="toctext">体育</span></a></li>

<li class="toclevel-1 tocsection-34"><a href="#友好城市"><span class="tocnumber">13</span> <span class="toctext">友好城市</span></a></li>

<li class="toclevel-1 tocsection-35"><a href="#注释"><span class="tocnumber">14</span> <span class="toctext">注释</span></a></li>

<li class="toclevel-1 tocsection-36"><a href="#参考文献"><span class="tocnumber">15</span> <span class="toctext">参考文献</span></a></li>

<li class="toclevel-1 tocsection-37"><a href="#外部链接"><span class="tocnumber">16</span> <span class="toctext">外部链接</span></a></li>

<li class="toclevel-1 tocsection-38"><a href="#参见"><span class="tocnumber">17</span> <span class="toctext">参见</span></a></li>

</ul>

</div>

<h2><span id=".E5.90.8D.E7.A7.B0"></span><span class="mw-headline" id="名称">名称</span><span class="mw-editsection"><span class="mw-editsection-bracket">[</span><a href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit&section=1" title="编辑章节:名称">编辑</a><span class="mw-editsection-bracket">]</span></span></h2>

<p>曾先后被称为<a href="/wiki/%E8%93%9F%E5%9F%8E" title="蓟城">蓟城</a>、<a href="/wiki/%E7%87%95%E9%83%BD" class="mw-redirect" title="燕都">燕中都</a>、燕京、<a href="/wiki/%E8%93%9F%E5%8E%BF%E5%9F%8E" class="mw-redirect" title="蓟县城">蓟县</a>、<a href="/wiki/%E5%B9%BF%E9%98%B3%E9%83%A1" title="广阳郡">广阳郡</a>、<a href="/wiki/%E5%B9%BF%E9%98%B3%E5%9B%BD" class="mw-redirect" title="广阳国">广阳国</a>、<a href="/wiki/%E5%B9%BD%E5%B7%9E" class="mw-redirect" title="幽州">幽州</a>、<a href="/wiki/%E5%B9%BF%E9%98%B3%E9%83%A1" title="广阳郡">燕国</a>、<a href="/wiki/%E7%87%95%E9%83%A1" title="燕郡">燕郡</a>、<a href="/wiki/%E6%B6%BF%E9%83%A1" title="涿郡">涿郡</a>、<a href="/wiki/%E8%8C%83%E9%98%B3%E8%8A%82%E5%BA%A6%E4%BD%BF" class="mw-redirect" title="范阳节度使">范阳</a>、<a href="/wiki/%E5%8D%A2%E9%BE%99%E8%8A%82%E5%BA%A6%E4%BD%BF" class="mw-redirect" title="卢龙节度使">卢龙</a>、南京<a href="/wiki/%E5%B9%BD%E9%83%BD%E5%BA%9C" title="幽都府">幽都府</a>、南京<a href="/wiki/%E6%9E%90%E6%B4%A5%E5%BA%9C" title="析津府">析津府</a>、<a href="/wiki/%E7%87%95%E5%B1%B1%E5%BA%9C%E8%B7%AF" title="燕山府路">燕山府路</a>、<a href="/wiki/%E9%87%91%E4%B8%AD%E9%83%BD" title="金中都">中都大兴府</a>、<a href="/wiki/%E4%B8%AD%E9%83%BD%E8%B7%AF" title="中都路">中都路</a>、<a href="/wiki/%E5%A4%A7%E9%83%BD" class="mw-redirect" title="大都">大都路</a><a href="/wiki/%E5%A4%A7%E5%85%B4%E5%BA%9C" title="大兴府">大兴府</a>、<a href="/wiki/%E5%8C%97%E5%B9%B3" class="mw-redirect" title="北平">北平府</a>、<a href="/wiki/%E5%8C%97%E4%BA%AC" class="mw-redirect" title="北京">北京</a>、<a href="/wiki/%E9%A0%86%E5%A4%A9%E5%BA%9C" title="順天府">京师</a>、<a href="/wiki/%E9%A1%BA%E5%A4%A9%E5%BA%9C" class="mw-redirect" title="顺天府">顺天府</a>、<a href="/wiki/%E4%BA%AC%E5%85%86%E5%9C%B0%E6%96%B9" title="京兆地方">京兆地方</a>、<a href="/wiki/%E5%8C%97%E5%B9%B3%E5%B8%82" title="北平市">北平特别市</a>等。现名北京市。有京城、京都、<a href="/wiki/%E4%BA%AC%E7%95%BF" class="mw-disambig" title="京畿">京畿</a>、京兆等非正式称呼。

</p>

<h2><span id=".E5.8E.86.E5.8F.B2"></span><span class="mw-headline" id="历史">历史</span><span class="mw-editsection"><span class="mw-editsection-bracket">[</span><a href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit&section=2" title="编辑章节:历史">编辑</a><span class="mw-editsection-bracket">]</span></span></h2>

<div role="note" class="hatnote navigation-not-searchable">主条目:<a href="/wiki/%E5%8C%97%E4%BA%AC%E5%8E%86%E5%8F%B2" title="北京历史">北京历史</a></div>

<h3><span id=".E5.8F.B2.E5.89.8D"></span><span class="mw-headline" id="史前">史前</span><span class="mw-editsection"><span class="mw-editsection-bracket">[</span><a href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit&section=3" title="编辑章节:史前">编辑</a><span class="mw-editsection-bracket">]</span></span></h3>

<p>距今60万年-2万年的时间内,北京地区处于<a href="/wiki/%E6%97%A7%E7%9F%B3%E5%99%A8%E6%97%B6%E4%BB%A3" title="旧石器时代">旧石器时代</a>,在周口店发现了旧石器时代早期<a href="/wiki/%E5%8C%97%E4%BA%AC%E7%9B%B4%E7%AB%8B%E4%BA%BA" class="mw-redirect" title="北京直立人">北京直立人</a>、中期<a href="/w/index.php?title=%E6%96%B0%E6%B4%9E%E4%BA%BA&action=edit&redlink=1" class="new" title="新洞人(页面不存在)">新洞人</a>和晚期<a href="/wiki/%E5%B1%B1%E9%A1%B6%E6%B4%9E%E4%BA%BA" title="山顶洞人">山顶洞人</a>的典型遗址。北京地区在不晚于1万年前已经开始进入<a href="/wiki/%E6%96%B0%E7%9F%B3%E5%99%A8%E6%97%B6%E4%BB%A3" title="新石器时代">新石器时代</a>。当时该地区人类定居生活固定化,逐渐从山洞中迁徙出来,到平原地区定居<sup id="cite_ref-15" class="reference"><a href="#cite_note-15">[14]</a></sup>。

</p>

<h3><span id=".E5.8F.A4.E4.BB.A3"></span><span class="mw-headline" id="古代">古代</span><span class="mw-editsection"><span class="mw-editsection-bracket">[</span><a href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit&section=4" title="编辑章节:古代">编辑</a><span class="mw-editsection-bracket">]</span></span></h3>

<p>北京作为城市的历史可以追溯到3,000年前。<a href="/wiki/%E8%A5%BF%E5%91%A8" title="西周">西周</a>初年,<a href="/wiki/%E5%91%A8%E6%AD%A6%E7%8E%8B" title="周武王">周武王</a>封<a href="/wiki/%E5%8F%AC%E5%85%AC%E5%A5%AD" title="召公奭">召公奭</a>于<a href="/wiki/%E7%87%95%E5%9C%8B" class="mw-redirect" title="燕國">燕國</a>。燕国早期都城位于今<a href="/wiki/%E6%88%BF%E5%B1%B1%E5%8C%BA" title="房山区">房山区</a><a href="/wiki/%E7%90%89%E7%92%83%E6%B2%B3%E9%81%97%E5%9D%80" title="琉璃河遗址">琉璃河遗址</a>。一些学者将琉璃河古城视为北京城的源头。据《史记》,周武王封尧的后人建立<a href="/wiki/%E8%96%8A%E5%9C%8B" title="薊國">蓟国</a>,都城为蓟。春秋时期,燕灭蓟,将都城迁至蓟。蓟城的具体位置尚有争议。郦道元《水经注》认为,蓟城的位置就在今天的北京。1950年代起,北京<a href="/wiki/%E5%AE%A3%E6%AD%A6%E9%97%A8" title="宣武门">宣武门</a>至<a href="/wiki/%E5%92%8C%E5%B9%B3%E9%97%A8_(%E5%8C%97%E4%BA%AC)" title="和平门 (北京)">和平门</a>一带的基建工程中发现了大量的春秋时代至西汉的陶井,学者据此认为蓟城的位置就在这一带,认为蓟城是北京城的起源。然而,这一区域并未发现西周时代的遗存,西周时蓟城的位置仍然未知。

</p><p>前222年,<a href="/wiki/%E7%A7%A6%E5%9B%BD" title="秦国">秦国</a>灭燕后,设北京为<a href="/wiki/%E8%93%9F%E5%8E%BF" class="mw-redirect" title="蓟县">蓟县</a>,为<a href="/wiki/%E5%B9%BF%E9%98%B3%E9%83%A1" title="广阳郡">广阳郡</a>郡治。汉<a href="/wiki/%E5%85%83%E5%87%A4" title="元凤">元凤</a>元年广阳郡蓟县属<a href="/wiki/%E5%B9%BD%E5%B7%9E" class="mw-redirect" title="幽州">幽州</a>管辖。<a href="/wiki/%E6%9C%AC%E5%A7%8B" title="本始">本始</a>元年更名为<a href="/wiki/%E5%B9%BF%E9%98%B3%E5%9B%BD" class="mw-redirect" title="广阳国">广阳国</a>首府。<a href="/wiki/%E4%B8%9C%E6%B1%89" title="东汉">东汉</a><a href="/wiki/%E5%85%89%E6%AD%A6%E5%B8%9D" class="mw-redirect" title="光武帝">光武</a>改制时,置幽州<a href="/wiki/%E5%88%BA%E5%8F%B2" title="刺史">刺史</a>部于蓟县。永元八年复为<a href="/wiki/%E5%B9%BF%E9%98%B3%E9%83%A1" title="广阳郡">广阳郡</a>治所。<a href="/wiki/%E8%A5%BF%E6%99%8B" title="西晋">西晋</a>时,朝廷改广阳郡为燕国,而幽州迁至<a href="/wiki/%E8%8C%83%E9%98%B3" title="范阳">范阳</a>。<a href="/wiki/%E5%8D%81%E5%85%AD%E5%9B%BD" class="mw-redirect" title="十六国">十六国</a><a href="/wiki/%E5%90%8E%E8%B5%B5" title="后赵">后赵</a>时,幽州驻所迁回蓟县,燕国改设为燕郡,历经<a href="/wiki/%E5%89%8D%E7%87%95" title="前燕">前燕</a>、<a href="/wiki/%E5%89%8D%E7%A7%A6" title="前秦">前秦</a>、<a href="/wiki/%E5%8C%97%E7%87%95" title="北燕">北燕</a>、<a href="/wiki/%E5%90%8E%E7%87%95" class="mw-redirect" title="后燕">后燕</a>和<a href="/wiki/%E5%8C%97%E9%AD%8F" title="北魏">北魏</a>的统治而不变。

</p><p><a href="/wiki/%E9%9A%8B%E6%9C%9D" title="隋朝">隋朝</a>开皇三年(583年)废除燕郡。但很快在大业三年(607年),<a href="/wiki/%E9%9A%8B%E6%9C%9D" title="隋朝">隋朝</a>改<a href="/wiki/%E5%B9%BD%E5%B7%9E" class="mw-redirect" title="幽州">幽州</a>为<a href="/wiki/%E6%B6%BF%E9%83%A1" title="涿郡">涿郡</a>。<a href="/wiki/%E5%94%90%E6%9C%9D" title="唐朝">唐朝</a><a href="/wiki/%E6%AD%A6%E5%BE%B7" title="武德">武德</a>年间,<a href="/wiki/%E6%B6%BF%E9%83%A1" title="涿郡">涿郡</a>复称为<a href="/wiki/%E5%B9%BD%E5%B7%9E" class="mw-redirect" title="幽州">幽州</a>。贞观元年,幽州划归<a href="/wiki/%E6%B2%B3%E5%8C%97%E9%81%93" title="河北道">河北道</a>监察区。后北京成为<a href="/wiki/%E8%8C%83%E9%98%B3%E8%8A%82%E5%BA%A6%E4%BD%BF" class="mw-redirect" title="范阳节度使">范阳节度使</a>的驻地。<a href="/wiki/%E5%AE%89%E5%8F%B2%E4%B9%8B%E4%B9%B1" class="mw-redirect" title="安史之乱">安史之乱</a>期间,杂胡<a href="/wiki/%E5%AE%89%E7%A6%84%E5%B1%B1" class="mw-redirect" title="安禄山">安禄山</a>在<a href="/wiki/%E8%8C%83%E9%99%BD" class="mw-redirect" title="范陽">范陽</a>(今日<a href="/wiki/%E5%8C%97%E4%BA%AC" class="mw-redirect" title="北京">北京</a>、<a href="/wiki/%E4%BF%9D%E5%AE%9A" class="mw-redirect" title="保定">保定</a>附近)称<a href="/wiki/%E7%9A%87%E5%B8%9D" title="皇帝">帝</a>,建国号为“<a href="/wiki/%E5%A4%A7%E7%87%95" class="mw-redirect" title="大燕">大燕</a>”。唐朝平乱后,复置幽州,归<a href="/wiki/%E5%8D%A2%E9%BE%99%E8%8A%82%E5%BA%A6%E4%BD%BF" class="mw-redirect" title="卢龙节度使">卢龙节度使</a>节制<span id="noteTag-cite_ref-sup"><sup id="cite_ref-16" class="reference"><a href="#cite_note-16">[註 2]</a></sup></span>。<a href="/wiki/%E4%BA%94%E4%BB%A3" class="mw-redirect" title="五代">五代</a>初期,军阀<a href="/wiki/%E5%88%98%E4%BB%81%E6%81%AD" class="mw-redirect" title="刘仁恭">刘仁恭</a>割据此地,后其子<a href="/wiki/%E5%88%98%E5%AE%88%E5%85%89" class="mw-redirect" title="刘守光">刘守光</a>称燕王,被<a href="/wiki/%E5%90%8E%E5%94%90" title="后唐">后唐</a>消灭。<a href="/wiki/%E5%90%8E%E6%99%8B" title="后晋">后晋</a>的建立者<a href="/wiki/%E6%B2%99%E9%99%80%E4%BA%BA" class="mw-redirect" title="沙陀人">沙陀人</a><a href="/wiki/%E7%9F%B3%E6%95%AC%E7%91%AD" title="石敬瑭">石敬瑭</a>为了打败后唐,投降<a href="/wiki/%E5%A5%91%E4%B8%B9%E4%BA%BA" title="契丹人">契丹人</a>,将<a href="/wiki/%E7%87%95%E9%9B%B2%E5%8D%81%E5%85%AD%E5%B7%9E" title="燕雲十六州">燕云十六州</a>在后晋天福元年(936年)送给<a href="/wiki/%E5%A5%91%E4%B8%B9" class="mw-redirect" title="契丹">契丹</a>,并向契丹称自己為<a href="/wiki/%E5%85%92%E7%9A%87%E5%B8%9D" class="mw-redirect" title="兒皇帝">儿皇帝</a>。石敬瑭割让包括今北京在内的<a href="/wiki/%E7%87%95%E9%9B%B2%E5%8D%81%E5%85%AD%E5%B7%9E" title="燕雲十六州">燕云十六州</a>为辽国或<a href="/wiki/%E9%87%91%E5%9B%BD" class="mw-redirect" title="金国">金国</a>后来对<a href="/wiki/%E5%90%8E%E6%B1%89" class="mw-redirect" title="后汉">后汉</a>、<a href="/wiki/%E5%90%8E%E5%91%A8" title="后周">后周</a>、<a href="/wiki/%E5%AE%8B%E6%9C%9D" title="宋朝">宋朝</a>威胁打开了门户。

</p><p><a href="/wiki/%E5%8C%97%E5%AE%8B" title="北宋">北宋</a>初年,<a href="/wiki/%E5%AE%8B%E5%A4%AA%E5%AE%97" title="宋太宗">宋太宗</a>在<a href="/wiki/%E9%AB%98%E6%A2%81%E6%B2%B3" title="高梁河">高梁河</a>(今北京市<a href="/wiki/%E6%B5%B7%E6%B7%80%E5%8C%BA" title="海淀区">海淀区</a>)与<a href="/wiki/%E8%BE%BD%E6%9C%9D" title="辽朝">辽</a>战斗,意图收复<a href="/wiki/%E7%87%95%E9%9B%B2%E5%8D%81%E5%85%AD%E5%B7%9E" title="燕雲十六州">燕云十六州</a>未果。<a href="/wiki/%E8%BE%BD%E6%9C%9D" title="辽朝">辽朝</a>于<a href="/wiki/%E4%BC%9A%E5%90%8C_(%E5%B9%B4%E5%8F%B7)" title="会同 (年号)">会同元年</a>起在北京地区建立了陪都,号<a href="/wiki/%E5%8D%97%E4%BA%AC%E5%B9%BD%E9%83%BD%E5%BA%9C" class="mw-redirect" title="南京幽都府">南京幽都府</a>;<a href="/wiki/%E9%96%8B%E6%B3%B0_(%E9%81%BC)" title="開泰 (遼)">开泰元年</a>改号<a href="/wiki/%E6%9E%90%E6%B4%A5%E5%BA%9C" title="析津府">析津府</a>。北宋末年,宋联金灭辽后收复<a href="/wiki/%E7%87%95%E9%9B%B2%E5%8D%81%E5%85%AD%E5%B7%9E" title="燕雲十六州">燕云十六州</a>,并设置<a href="/wiki/%E7%87%95%E5%B1%B1%E5%BA%9C%E8%B7%AF" title="燕山府路">燕山府路</a>和<a href="/wiki/%E9%9B%B2%E4%B8%AD%E5%BA%9C%E8%B7%AF" class="mw-redirect" title="雲中府路">云中府路</a>,北京属于燕山府路。<a href="/wiki/%E9%87%91%E6%9C%9D" title="金朝">金朝</a>以<a href="/wiki/%E5%BC%B5%E8%A6%BA" title="張覺">张觉</a>事件为借口大举攻宋,再次出兵<a href="/wiki/%E7%87%95%E5%B1%B1%E5%BA%9C" title="燕山府">燕山府</a>。<a href="/wiki/%E9%87%91%E6%9C%9D" title="金朝">金朝</a><a href="/wiki/%E8%B4%9E%E5%85%83_(%E9%87%91%E6%9C%9D)" title="贞元 (金朝)">贞元</a>元年(1153年),<a href="/wiki/%E5%AE%8C%E9%A2%9C%E4%BA%AE" class="mw-redirect" title="完颜亮">完颜亮</a>正式迁都于北京,改燕京为圣都,不久又称<a href="/wiki/%E9%87%91%E4%B8%AD%E9%83%BD" title="金中都">中都大兴府</a>,这是北京历史上第一次成为中国的首都,至今已有八百余年建都史。<a href="/wiki/%E9%87%91%E4%B8%AD%E9%83%BD" title="金中都">金中都</a>的建成使北京成为当时世界上最繁华的商业大都市,人口超过一百万,城内居住着众多部族,东西方众多文化在这里交流融合,北京从此成为国际性都市。完颜亮在中都之东开通了潞河,潞城因此改名<a href="/wiki/%E9%80%9A%E5%B7%9E_(%E5%8C%97%E4%BA%AC)" title="通州 (北京)">通州</a>,西面则建成<a href="/wiki/%E5%8D%A2%E6%B2%9F%E6%A1%A5" title="卢沟桥">卢沟桥</a><span id="noteTag-cite_ref-sup"><sup id="cite_ref-17" class="reference"><a href="#cite_note-17">[註 3]</a></sup></span>,使西南陆路各种货物可以直接进入中都。金代还首创了漕运形式,即从水路运送粮米到京城。

</p><p>蒙古帝国<a href="/wiki/%E6%88%90%E5%90%89%E6%80%9D%E6%B1%97" title="成吉思汗">成吉思汗</a>麾下大将<a href="/wiki/%E6%9C%A8%E5%8D%8E%E9%BB%8E" title="木华黎">木华黎</a>从1214年农历五月开始到1215年农历五月攻下金中都,对中都整整围困了将近一年之久。城破后展开了为期一个月的大屠杀,超过百万人殒命,又纵火焚城,几乎彻底毁灭了这座城市<sup id="cite_ref-18" class="reference"><a href="#cite_note-18">[15]</a></sup>。金朝著名大词人<a href="/wiki/%E5%85%83%E5%A5%BD%E9%97%AE" title="元好问">元好问</a>的胞兄元好古也在屠城中丧命。<a href="/wiki/%E5%BF%BD%E5%BF%85%E7%83%88" title="忽必烈">忽必烈</a>1260年即位後,決定以漢地作為統治基礎,將燕京定為首都,至元元年(1264年)改稱中都路大兴府。至元九年(1272年),中都大兴府正式改名为<a href="/wiki/%E5%85%83%E5%A4%A7%E9%83%BD" title="元大都">大都路</a><span id="noteTag-cite_ref-sup"><sup id="cite_ref-19" class="reference"><a href="#cite_note-19">[註 4]</a></sup></span>。

</p><p><a href="/wiki/%E6%98%8E%E6%9C%9D" title="明朝">明朝</a>初年,<a href="/wiki/%E6%9C%B1%E5%85%83%E7%92%8B" title="朱元璋">朱元璋</a>以<a href="/wiki/%E9%87%91%E9%99%B5" class="mw-redirect" title="金陵">金陵</a><a href="/wiki/%E5%BA%94%E5%A4%A9%E5%BA%9C_(%E6%98%8E%E6%9C%9D)" title="应天府 (明朝)">应天府</a>(今<a href="/wiki/%E5%8D%97%E4%BA%AC%E5%B8%82" title="南京市">南京市</a>)为京师,大都路于洪武元年八月被明軍收復,改称为北平府,同年十月应军事需要划归<a href="/wiki/%E5%B1%B1%E4%B8%9C" class="mw-redirect" title="山东">山东</a><a href="/wiki/%E8%A1%8C%E7%9C%81" class="mw-redirect" title="行省">行省</a>。洪武二年三月,改为北平<a href="/wiki/%E6%89%BF%E5%AE%A3%E5%B8%83%E6%94%BF%E4%BD%BF%E5%8F%B8" title="承宣布政使司">承宣布政使司</a>驻地。燕王<a href="/wiki/%E6%9C%B1%E6%A3%A3" class="mw-redirect" title="朱棣">朱棣</a>经<a href="/wiki/%E9%9D%96%E9%9A%BE" class="mw-redirect" title="靖难">靖难</a>之变夺得皇位后,于<a href="/wiki/%E6%B0%B8%E4%B9%90_(%E6%98%8E%E6%9C%9D)" title="永乐 (明朝)">永乐</a>元年(1402年)升<a href="/wiki/%E7%87%95%E4%BA%AC" class="mw-redirect" title="燕京">燕京</a>北平为北京,暫稱“<a href="/wiki/%E8%A1%8C%E5%9C%A8" title="行在">行在</a>”(<a href="/wiki/%E5%A4%A9%E5%AD%90" title="天子">天子</a>行銮驻跸的所在,就称“行在”)且在北伐時常驻于此,现在的北京也从此得名。朱棣行在北京后,一改元態,北京城秩序井然,繁榮安樂。永乐十九年正月,明成祖<a href="/wiki/%E6%9C%B1%E6%A3%A3" class="mw-redirect" title="朱棣">朱棣</a>正式<a href="/wiki/%E6%B0%B8%E6%A8%82%E9%81%B7%E9%83%BD" class="mw-redirect" title="永樂遷都">移鼎燕京</a>,以燕京为<a href="/wiki/%E9%A6%96%E9%83%BD" title="首都">京师</a>,稱為「北京」。金陵应天府则作为<a href="/wiki/%E7%95%99%E9%83%BD" class="mw-redirect" title="留都">留都</a>,称<a href="/wiki/%E5%8D%97%E4%BA%AC" class="mw-redirect" title="南京">南京</a>。<a href="/wiki/%E6%98%8E%E4%BB%81%E5%AE%97" title="明仁宗">明仁宗</a>及<a href="/wiki/%E6%98%8E%E5%AE%A3%E5%AE%97" title="明宣宗">明宣宗</a>的时期,因<a href="/wiki/%E7%9A%87%E5%B8%9D" title="皇帝">皇帝</a>個人的喜好因素,北京之<a href="/wiki/%E4%BA%AC%E5%B8%88" class="mw-redirect mw-disambig" title="京师">京师</a>地位一度降為<a href="/wiki/%E5%90%9B%E4%B8%BB" title="君主">君主</a>暫幸之<a href="/wiki/%E8%A1%8C%E5%9C%A8" title="行在">行在</a>,复稱金陵应天府為南京,<a href="/wiki/%E6%98%8E%E8%8B%B1%E5%AE%97" title="明英宗">明英宗</a>親政後,<a href="/wiki/%E6%AD%A3%E7%BB%9F_(%E5%B9%B4%E5%8F%B7)" title="正统 (年号)">正統</a>七年(1441年)時才恢復燕京京师的地位。

</p><p>1626年5月30日,北京西南隅的工部王恭厂火药库发生<a href="/wiki/%E7%8E%8B%E6%81%AD%E5%BB%A0%E5%A4%A7%E7%88%86%E7%82%B8" title="王恭廠大爆炸">王恭厰大爆炸</a>,死伤2万多人<sup id="cite_ref-20" class="reference"><a href="#cite_note-20">[16]</a></sup>,原因不明,朝野震惊,中外骇然,<a href="/wiki/%E6%98%8E%E7%86%B9%E5%AE%97" title="明熹宗">明熹宗</a>下了一道<a href="/wiki/%E7%BD%AA%E5%B7%B1%E8%AF%8F" title="罪己诏">罪己诏</a>,表示要痛加省醒,告诫大小臣工“务要竭虑洗心办事,痛加反省”,并下旨发府库万两黄金赈灾。1643年,北京内爆发<a href="/wiki/%E6%98%8E%E6%9C%AB%E5%A4%A7%E9%BC%A0%E7%96%AB" title="明末大鼠疫">明末大鼠疫</a>重大疫情、造成20多万人死亡,被认为是明朝灭亡的重要因素之一<sup id="cite_ref-:0_21-0" class="reference"><a href="#cite_note-:0-21">[17]</a></sup><sup id="cite_ref-:1_22-0" class="reference"><a href="#cite_note-:1-22">[18]</a></sup><sup id="cite_ref-:2_23-0" class="reference"><a href="#cite_note-:2-23">[19]</a></sup><sup id="cite_ref-:3_24-0" class="reference"><a href="#cite_note-:3-24">[20]</a></sup>。1644年4月25日,<a href="/wiki/%E6%9D%8E%E8%87%AA%E6%88%90" title="李自成">李自成</a>攻陷北京,<a href="/wiki/%E5%B4%87%E7%A5%AF%E5%B8%9D" class="mw-redirect" title="崇祯帝">崇祯帝</a>在<a href="/wiki/%E7%85%A4%E5%B1%B1" class="mw-redirect" title="煤山">煤山</a><a href="/wiki/%E8%87%AA%E7%B8%8A" class="mw-redirect" title="自縊">自縊</a>,<a href="/wiki/%E7%94%B2%E7%94%B3%E4%B9%8B%E8%AE%8A" title="甲申之變">明朝滅亡</a>。清朝<a href="/wiki/%E9%A0%86%E6%B2%BB%E5%B8%9D" class="mw-redirect" title="順治帝">順治帝</a><a href="/wiki/%E6%98%8E%E6%B8%85%E6%88%98%E4%BA%89" title="明清战争">入关</a>后即迁都北京,亦称为京师<a href="/wiki/%E9%A1%BA%E5%A4%A9%E5%BA%9C" class="mw-redirect" title="顺天府">顺天府</a>,属<a href="/wiki/%E7%9B%B4%E9%9A%B6%E7%9C%81" title="直隶省">直隶省</a>。清廷在北京实行旗民分居政策,即满汉蒙<a href="/wiki/%E5%85%AB%E6%97%97" title="八旗">八旗</a>居住内城,非旗籍<a href="/wiki/%E6%B1%89%E4%BA%BA" class="mw-redirect" title="汉人">汉人</a>和<a href="/wiki/%E5%9B%9E%E6%97%8F" title="回族">回民</a>居住外城。<a href="/wiki/%E5%85%AB%E6%97%97%E5%88%B6%E5%BA%A6" class="mw-redirect" title="八旗制度">旗人</a>事务由<a href="/wiki/%E4%B9%9D%E9%97%A8%E6%8F%90%E7%9D%A3" class="mw-redirect" title="九门提督">九門提督</a>管理,而<a href="/wiki/%E6%B1%89%E6%97%8F" title="汉族">汉族</a>、<a href="/wiki/%E5%9B%9E%E6%97%8F" title="回族">回族</a>事务则交给<a href="/wiki/%E9%A1%BA%E5%A4%A9%E5%BA%9C" class="mw-redirect" title="顺天府">顺天府</a><a href="/wiki/%E8%A1%99%E9%97%A8" class="mw-redirect" title="衙门">衙门</a>管理。

</p>

<h3><span id=".E8.BF.91.E4.BB.A3"></span><span class="mw-headline" id="近代">近代</span><span class="mw-editsection"><span class="mw-editsection-bracket">[</span><a href="/w/index.php?title=%E5%8C%97%E4%BA%AC%E5%B8%82&action=edit&section=5" title="编辑章节:近代">编辑</a><span class="mw-editsection-bracket">]</span></span></h3>

<p>1853年8月28日,<a href="/wiki/%E5%A4%AA%E5%B9%B3%E5%86%9B" class="mw-redirect" title="太平军">太平军</a>攻克<a href="/wiki/%E4%B8%B4%E6%B4%BA%E5%85%B3%E9%95%87" title="临洺关镇">临洺关镇</a>,北京大批人口逃离,全城戒严,人心惶惶之际,物价飞腾,米珠薪桂,一片混乱。

</p><p>1860年9月21日,<a href="/wiki/%E7%AC%AC%E4%BA%8C%E6%AC%A1%E9%B8%A6%E7%89%87%E6%88%98%E4%BA%89" title="第二次鸦片战争">英法联军</a>在<a href="/wiki/%E5%85%AB%E9%87%8C%E6%A9%8B%E4%B9%8B%E6%88%B0" title="八里橋之戰">八里桥之战</a>中打败清军,随后攻破北京城,放火烧毁<a href="/wiki/%E5%9C%93%E6%98%8E%E5%9C%92" class="mw-redirect" title="圓明園">圆明园</a>,<a href="/wiki/%E5%92%B8%E4%B8%B0%E5%B8%9D" title="咸丰帝">咸丰帝</a>逃至<a href="/wiki/%E6%89%BF%E5%BE%B7%E5%B8%82" title="承德市">承德</a>。10月至11月,清政府与英法俄在<a href="/wiki/%E7%A4%BC%E9%83%A8" title="礼部">礼部</a>衙门签订《<a href="/wiki/%E5%8C%97%E4%BA%AC%E6%9D%A1%E7%BA%A6" title="北京条约">北京条约</a>》,外国<a href="/wiki/%E4%BD%BF%E8%8A%82" title="使节">使节</a>和<a href="/wiki/%E5%9F%BA%E7%9D%A3%E6%95%99" title="基督教">基督教</a><a href="/wiki/%E4%BC%A0%E6%95%99%E5%A3%AB" title="传教士">传教士</a>得到特许允进北京,在城内各处兴建<a href="/wiki/%E6%95%99%E5%A0%82" title="教堂">教堂</a>,使馆则集中在<a href="/wiki/%E4%B8%9C%E4%BA%A4%E6%B0%91%E5%B7%B7" title="东交民巷">东交民巷</a><sup id="cite_ref-1860年北京条约_25-0" class="reference"><a href="#cite_note-1860年北京条约-25">[21]</a></sup>。1888年,北京第一条<a href="/wiki/%E9%93%81%E8%B7%AF" class="mw-redirect" title="铁路">铁路</a><a href="/wiki/%E8%A5%BF%E8%8B%91%E9%93%81%E8%B7%AF" title="西苑铁路">西苑铁路</a>在<a href="/wiki/%E4%B8%AD%E5%8D%97%E6%B5%B7" title="中南海">中南海</a>建成,但该铁路并非营业性质<sup id="cite_ref-bj-general_26-0" class="reference"><a href="#cite_note-bj-general-26">[22]</a></sup><sup class="reference" style="white-space:nowrap;">:73</sup>,已于1925年被拆除,此后北京的第一条营业铁路为1897年通车的<a href="/wiki/%E6%B4%A5%E8%8A%A6%E9%93%81%E8%B7%AF" title="津芦铁路">津芦铁路</a><sup id="cite_ref-bj-general_26-1" class="reference"><a href="#cite_note-bj-general-26">[22]</a></sup><sup class="reference" style="white-space:nowrap;">:72</sup>。

</p><p>1900年6月,<a href="/wiki/%E4%B9%89%E5%92%8C%E5%9B%A2%E8%BF%90%E5%8A%A8" title="义和团运动">义和团</a>进入北京,烧毁城内教堂,并围攻各国使馆。8月,<a href="/wiki/%E5%85%AB%E5%9C%8B%E8%81%AF%E8%BB%8D" title="八國聯軍">八国联军</a>攻占北京,解救被义和团围攻的各国公使。1901年8月,八国联军从北京撤军。9月7日,清政府同西方签订《<a href="/wiki/%E8%BE%9B%E4%B8%91%E6%9D%A1%E7%BA%A6" title="辛丑条约">辛丑条约</a>》。同年,西便门和东便门城墙上各开一铁路豁口,成为对北京城墙最早的改造<sup id="cite_ref-bj-general_26-2" class="reference"><a href="#cite_note-bj-general-26">[22]</a></sup><sup class="reference" style="white-space:nowrap;">:72</sup>。1902年1月,<a href="/wiki/%E6%85%88%E7%A6%A7%E5%A4%AA%E5%90%8E" title="慈禧太后">慈禧太后</a>和<a href="/wiki/%E5%85%89%E7%BB%AA%E5%B8%9D" title="光绪帝">光绪帝</a>回到北京下<a href="/wiki/%E7%BD%AA%E5%B7%B1%E8%AF%8F" title="罪己诏">罪己诏</a>。1909年,连接北京至<a href="/wiki/%E5%BC%A0%E5%AE%B6%E5%8F%A3%E5%B8%82" title="张家口市">张家口</a>的<a href="/wiki/%E4%BA%AC%E5%BC%A0%E9%93%81%E8%B7%AF" title="京张铁路">京张铁路</a>在<a href="/wiki/%E8%A9%B9%E5%A4%A9%E4%BD%91" title="詹天佑">詹天佑</a>的主持下建成通车<sup id="cite_ref-bj-general_26-3" class="reference"><a href="#cite_note-bj-general-26">[22]</a></sup><sup class="reference" style="white-space:nowrap;">:73</sup>。1911年3月30日,<a href="/wiki/%E6%B8%85%E5%8D%8E%E5%A4%A7%E5%AD%A6" title="清华大学">清华大学</a>成立。

</p>

<link rel="mw-deduplicated-inline-style" href="mw-data:TemplateStyles:r61200722/mw-parser-output/.tmulti"/><div class="thumb tmulti tleft"><div class="thumbinner" style="width:272px;max-width:272px"><div class="trow"><div class="tsingle" style="width:164px;max-width:164px"><div class="thumbimage" style="height:128px;overflow:hidden"><a href="/wiki/File:ROC_Div_City_Peiping_2.svg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/1/13/ROC_Div_City_Peiping_2.svg/162px-ROC_Div_City_Peiping_2.svg.png" decoding="async" width="162" height="128" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/1/13/ROC_Div_City_Peiping_2.svg/243px-ROC_Div_City_Peiping_2.svg.png 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/1/13/ROC_Div_City_Peiping_2.svg/324px-ROC_Div_City_Peiping_2.svg.png 2x" data-file-width="677" data-file-height="535" /></a></div><div class="thumbcaption text-align-center"><a href="/wiki/%E4%B8%AD%E8%8F%AF%E6%B0%91%E5%9C%8B" title="中華民國">中華民國</a>北平市</div></div><div class="tsingle" style="width:104px;max-width:104px"><div class="thumbimage" style="height:128px;overflow:hidden"><a href="/wiki/File:Beijing_1948_JP.jpg" class="image"><img alt="" src="//upload.wikimedia.org/wikipedia/commons/thumb/4/4b/Beijing_1948_JP.jpg/102px-Beijing_1948_JP.jpg" decoding="async" width="102" height="129" srcset="//upload.wikimedia.org/wikipedia/commons/thumb/4/4b/Beijing_1948_JP.jpg/153px-Beijing_1948_JP.jpg 1.5x, //upload.wikimedia.org/wikipedia/commons/thumb/4/4b/Beijing_1948_JP.jpg/204px-Beijing_1948_JP.jpg 2x" data-file-width="6293" data-file-height="7933" /></a></div><div class="thumbcaption text-align-center">1940年代的北京城區</div></div></div></div></div>